平台介绍¶

校级高性能计算平台,由 arm 和 x86 两类芯片架构的CPU节点组成,作业调度系统采用的多瑙(Donau Scheduler)。

使用指南¶

-

在满足本实验室正常使用的情况下,面向全校师生开放使用,每学年4次集中考核、申请;收费标准

-

禁止在登录节点运行作业,登录节点运行的程序使用CPU或内存超标会被监控程序杀掉。所有作业应由多瑙作业调度系统调度至计算节点运行,多瑙使用文档见 多瑙使用。

-

多瑙作业资源申请规则及注意事项:

- 多瑙作业申请资源时需遵守资源申请的基本规则,即申请的CPU核心数和程序使用的线程数相等,避免集群资源的浪费或者节点负载过高,如果违反规则导致资源大规模浪费,账号将会被暂停提交作业一段时间或降低可使用的核心数;

-

本集群拥有用 ARM 和 X86 两类架构的 CPU,其上运行的软件有差异,即在 ARM 上编译的软件无法在 X86 节点运行、在 X86 上编译的软件无法在 ARM 节点运行。鉴于此,建议用户在 ARM 上运行作业时,尽可能使用集群上编译安装好的公共软件,见 公共软件。在 X86 节点上运行作业时可自行在 X86 登录节点编译安装应用软件。bioconda 中的软件绝大部分都是基于 X86 编译的,因此如果需要使用 bioconda 中的应用软件,建议在 X86 节点安装 conda(或 mamba),然后再安装所需的应用软件。

-

每个用户可使用的计算和存储资源有一定限制。数据较多、作业任务较多的用户建议时常使用

diskquota命令查看自己的存储使用量,以免因为存储空间达到配额限制导致程序挂掉。存储超配额后,无法写入数据,同时也无法登录集群,均会出现Disk quota exceeded的报错。 -

集群存储只存储用户目前使用的数据,结果数据应该及时下载到本地,计算中间数据及时删除。测序原始数据一定要在本地备一份。长时间不使用的数据及时压缩后备份到本地,避免额外的存储使用费用。删除数据前请仔细确认,集群上的数据删除后不可恢复。

-

NR、NT等生信数据库目录

/share/software/biodb/。 -

大批量的群体数据处理时,不要直接保留sam文件,见 短序列比对输出bam, 数据使用规范 。群体数据处理过程中会使用大量的存储空间,建议群体数据处理过程中时常使用

diskquota命令查看自己的存储使用量,以免存储使用达到配额限制导致程序挂掉或空跑。

平台使用 ↵

计算资源¶

华中农业大学超算平台集群计算资源包含2类资源,一类为HPC算力(x86),一类为HPC算力(ARM),其中x86资源包含:2台登录节点、58台计算节点、3台大内存节点;ARM 资源包含:1台运维节点、2台登录节点、2台管理节点、43台计算节点、1台NPU节点、3台大内存节点。

各节点详细硬件配置如下:

| 节点类型 | 算力类型 | 节点名称 | 节点数量 | CPU型号 | 核心数 | 内存 |

|---|---|---|---|---|---|---|

| 登录节点 | x86 | cli_X86_01 cli_X86_02 | 2 | Intel Xeon Sliver 4316, 2.3GHz, 20c | 20 | 512G |

| 计算节点 | x86 | agent_X86_01 ~ agent_X86_58 | 58 | Intel Xeon Platinum 8358P, 2.6GHz, 32c | 64 | 512G |

| 大内存节点 | x86 | fat_agent_X86_01 ~ fat_agent_X86_03 | 3 | Intel Xeon Platinum 8358P, 2.6 GHz, 32c | 64 | 2048G |

| 运维节点 | arm | eSightSever | 1 | 鲲鹏 920, 2.6GHz, 32c | 64 | 64G |

| 管理节点 | arm | master_01 master_02 | 2 | 鲲鹏 920, 2.6GHz, 64c | 128 | 512GB |

| 登录节点 | arm | cli_ARM_01 cli_ARM_02 | 2 | 鲲鹏 920, 2.6GHz, 64c | 128 | 512GB |

| 计算节点 | arm | agent_ARM_01 ~ agent_ARM_43 | 43 | 鲲鹏920, 2.6GHz, 64c | 128 | 512GB |

| NPU节点 | arm | AI-node | 1 | 鲲鹏 920, 2.6GHz, 48c ;8 路昇腾 NPU AI,单AI规格为313TFlops@FP16,64GB HBM | 128 | 1024G |

| 大内存节点 | arm | fat_agent_ARM_01 ~ fat_agent_ARM_03 | 3 | 鲲鹏920, 2.9GHz, 64c | 128 | 2048G |

存储资源¶

存储资源包含1框8节点华为全闪存储OceanStor Pacific 9950,4框8节点华为大容量存储OceanStor Pacific 9550,其中9550采用DPC+标准协议组网场景,2个25G端口上行连到业务面接入交换机,每节点2个100GE端口接入到计算存储接入交换机,1个GE端口连到带外管理接入交换机。9950采用DPC组网场景,每节点2个100GE端口接入到计算存储接入交换机,1个GE端口连到带外管理接入交换机。

全闪存储OceanStor Pacific 9950单节点数据盘10块7.68TB SSD,总体提供可用容量460TB。大容量存储OceanStor Pacific 9550 单节点数据盘60块16TB SATA,单节点缓存盘4块1.6TB NVME SSD,提供可用容量5.8PB。

网络资源¶

网络资源包含22台交换机、2台防火墙。集群网络分为四个网络平面,计算/存储网络、业务面网络、带外管理网络、外网接入区。

计算/存储网络采用RoCE网络技术,通过AI人工智能等RoCEv2分布式应用提供“无丢包、低时延、高吞吐”的网络环境,满足分布式应用的高性能需求;管理网络采用Spine-Leaf架构,用于管理节点上集群管理软件收集集群各个节点状态信息(如CPU状态、内存使用率、磁盘使用率、在线状态等),并实现管理功能(如时间同步、集群部署、用户管理、作业调度等);带外管理网络通过SNMP技术,带外管理网络和设备的各种状态,主要用于网络设备、计算节点、存储节点等带外监控。

集群整体架构¶

| 资源类型 | 单位 | 校内(元) | 校外(元) |

|---|---|---|---|

| ARM 节点 | 核时 | 0.04 | 0.08 |

| X86 节点 | 核时 | 0.05 | 0.1 |

| NPU 节点 | 卡时 | 4 | 8 |

| 存储 | GB/月 | 0.025 | 0.05 |

帐号申请¶

用户范围¶

本系统实行收费使用的管理办法,面向全校师生开放使用。

帐号申请时间¶

本集群每学期初和学期中(第12周左右)开放一次申请、考核,具体的通知会发到超算网站(hpc.hzau.edu.cn)、超算用户QQ群、公众号(作物遗传改良卓越工程师工作室)等处。由于各种原因错过每学期帐号申请的同学,需等到下次开放申请。

帐号申请流程¶

- 学期初或12周左右,管理员下发集群开放申请通知,并开放集群考核报名的在线文档,如果有需要可填写报名文档参加考核。时间约为一周,期间练习账号也会开放,可向管理员申请使用。

- 申请用户参加集群用户考核,考核形式为纸质试卷+上机测试,考核内容见 集群考试内容。考试为开卷考试,可以携带学习资料、使用机房电脑搜索查询等。

- 考核80分通过,通过的申请用户需在企业微信上提交

超算账号申请审批单,审批人为导师。 - 管理员开通集群帐号,并将相关信息发到申请用户邮箱。

使用企业微信提请账号审批流程¶

如果没有加入“华中农大微校园”企业微信,可以按链接中的指南加入,企业微信加入指南

通过企微提请一个新集群账号申请的审批单,审批人为导师,

审批的位置:打开企微app->工作台->审批

导师审批的位置:工作台->审批->我的审批

计算资源限制¶

x86 计算资源(x86、fat_x86队列)每人可同时使用 1200 核,ARM 计算资源(arm、fat_arm 队列)每人可同时使用 2000 核。

存储资源¶

目前对每个新用户所能使用的存储空间限制为10TB,超过配额账号无法写入数据。当系统总的存储使用过高时会通知大家清理数据。

查看账号存储使用¶

用户可使用diskquota 命令查看当前存储使用量和配额,避免写满。特别是当有产生大量中间文件和结果文件的作业运行时,需时时关注,及时清理,以免超过配额。由于海量的小文件(小于128KB)会对存储系统性能有一定影响,因此大量小文件使用完之后需要即使删除或者打包压缩存放。

如下,当前的存储使用量为 5339125964800KB,存储配额为 10995116277760 KB;账号下文件数据量为 2097711,文件数配额为 1000000000;

$ diskquota

username space_used(KB) space_quota(KB) files_used files_quota

-------- -------------- --------------- ---------- -----------

user 5339125964800 10995116277760 2097711 1000000000

Disk quota exceeded。清理账号下的数据至配额之下方可正常写入数据。

$ diskquota

username space_used(KB) space_quota(KB) files_used files_quota

-------- -------------- --------------- ---------- -----------

user 15339125964800 10995116277760 2097711 1000000000

$ cp data/NT/taxdb.btd.gz .

cp: error writing ‘./taxdb.btd.gz’: Disk quota exceeded

cp: failed to extend ‘./taxdb.btd.gz’: Disk quota exceeded

命令行¶

参考

Warning

第一次使用多瑙调度器之前需要执行 dlogin ,输入用户密码后获取用户token。

作业提交¶

dsub

命令行提交作业¶

dsub -n jobname -q arm -aa -R 'cpu=4' -o jobname_%J.out sleep 100

脚本提交作业¶

#!/bin/bash

#DSUB -n jobname

#DSUB -R 'cpu=2'

#DSUB -o jobname_%J.out

#DSUB -aa

#DSUB -q arm

date

echo "this is script job"

sleep 10

date

提交

# 作业脚本需要有可执行权限

$ chmod +x submit.sh

$ dsub -s submit.sh

-

-n指定作业名称。 -

-R作业申请的资源,-R 'cpu=2申请 2 个 CPU 核。 -

-aa使用任意 CPU 架构的计算节点。 -

-q指定作业列,-q arm指定使用 arm 队列,作业队列的详细说明见下文的 作业队列。-q选项和-aa选项需一起使用。

-

-nl指定作业运行的节点,如#DSUB -nl 'agent-ARM-01';也可以指定作业运行的节点范围,#DSUB -nl 'agent-ARM-0[1-9]'。 -

-o指定作业日志。-o以追加的方式写入,-oo以覆盖的方式写入。日志文件名可以使用特殊变量:%U表示userName;%J表示JobID;%G表示TaskGroupName;%I表示Index;%A表示UserName_JobID_TaskGroupName_Index。

dsub -w 提交阻塞式作业,提交作业并等待作业结束,用于写分析流程,与 lsf -K 作用相同。

Warning

目前已弃用使用标签对资源进行分类使用的方式,请使用队列的方式将作业提交到 arm 或 x86 节点。作业队列

资源标签:集群有多种硬件资源,arm 节点、x86 节点、ai 节点以及胖节点,集群上使用不同的资源标签代表不同类型的节点,以方便作业提交到对应类型的节点运行,可以使用 dadmin label show 查看资源标签及对应的节点。

交互作业¶

使用 -I 选项可以提交交互作业,用于程序调试等。

$ dsub -q interactive -I bash

交互模式进入 AI 节点,AI 节点使用需要向管理员申请。

$ dsub -aa -q AI -I bash

MPI 并行作业¶

提交MPI跨节点并行作业时,需要使用 --mpi 选项指定支持的MPI类型,支持 openmpi,intelmpi,hmpi和mpich。

这里以 lammps 为例。

#DSUB -n lammps

#DSUB -N 256

#DSUB -nn 2

#DSUB --mpi hmpi

#DSUB -o lammps_arm_%J.out

#DSUB -aa

#DSUB -q arm

module load arm/lammps/29Aug2024_hmpi

# 以下三行打印hostfile文件,用于debug,正常运行可以不需要

echo $CCS_MPI_OPTIONS

hostfile=$(echo $CCS_MPI_OPTIONS| sed s'/-hostfile //g')

cat $hostfile

mpirun $CCS_MPI_OPTIONS -x OMP_NUM_THREADS=1 lmp_mpi -in in.lj

# 3d Lennard-Jones melt

variable x index 4

variable y index 4

variable z index 4

variable xx equal 20*$x

variable yy equal 20*$y

variable zz equal 20*$z

units lj

atom_style atomic

lattice fcc 0.8442

region box block 0 ${xx} 0 ${yy} 0 ${zz}

create_box 1 box

create_atoms 1 box

mass 1 1.0

velocity all create 1.44 87287 loop geom

pair_style lj/cut 2.5

pair_coeff 1 1 1.0 1.0 2.5

neighbor 0.3 bin

neigh_modify delay 0 every 20 check no

fix 1 all nve

run 10000

提交 NPU 作业¶

NPU 作业脚本,使用 -R 'npu=1' 选项申请 NPU 资源。

#!/bin/bash

#DSUB -n jobname

#DSUB -R 'npu=1'

#DSUB -o jobname_%J.out

#DSUB -aa

#DSUB -q AI

python npu.py

dnode --npu 命令可以查看集群 NPU 的使用情况。

$ dnode --npu

NAME NPU_ID DEVICE_ID NPU_NAME STATUS AICORE_UTIL DDR_USAGE HBM_USAGE

AI-01 0 0 Atlas A2 OK 0% 0/0 64433/655*

AI-01 1 0 Atlas A2 OK 0% 0/0 64890/655*

AI-01 2 0 Atlas A2 OK 0% 0/0 63353/655*

AI-01 3 0 Atlas A2 OK 0% 0/0 63353/655*

AI-01 4 0 Atlas A2 OK 0% 0/0 63359/655*

AI-01 5 0 Atlas A2 OK 0% 0/0 63353/655*

AI-01 6 0 Atlas A2 OK 0% 0/0 63353/655*

AI-01 7 0 Atlas A2 OK 0% 0/0 63355/655*

批量作业提交¶

一般用于使用同一个应用程序处理多个数据样本、或运行不同参数的场景,以提高作业提交效率、避免手工提交失误。

for sample in /share/home/username/work/lsf_bwait/raw_data/*_R1.fastq.gz;do

index=$(basename $sample |sed 's/_R1.fastq.gz//')

prefix=$(dirname $sample)

dsub -n "bwa_${prefix}" -aa -q arm -R 'cpu=40' -o bwa_${prefix}_%J.out "module load arm/bwa/0.7.18 arm/samtools/1.21;bwa mem -t 40 -R "@RG\tID:${prefix}\tPL:illumina\tLB:library\tSM:humen146" hg38.fa ${prefix}_R1.fastq.gz ${prefix}_R2.fastq.gz |samtools sort -@ 40 -o ${prefix}_srt.bam"

作业依赖¶

用于提交作业时,指定作业间的依赖关系,当被依赖的作业达成约定的状态后依赖的作业将会被调度。

dsub -D "key=value"

-

输入的参数值必须满足

key=value格式。key支持jobid和JobName,value值只能是STARTED、RUNNING、SUCCEEDED、FAILED、ENDED,如'2=ENDED'。STARTED表示RUNNING、STOPPED、SSTOPPED、SUCCEEDED和FAILED。ENDED表示SUCCEEDED和FAILED。

-

jobid约束如下:

- 必须满足jobid的限制条件,即1~12位正整数。

- 支持指定同一个jobid的多种状态,但指定同一作业的不同状态为与逻辑时,将导致依赖无法达成。

-

JobName约束如下:

- 若包含特殊字符

%=()|,需要使用\对特殊字符进行转义。 - 支持使用通配符

(*)模糊查询,可放置开头、中间或结尾,分别对应的匹配方式为后缀匹配、关键字匹配和前缀匹配。 - 只能依赖本用户提交的作业。

- 若包含特殊字符

-

多个匹配条件组合时,支持多匹配条件间的

“与(&&)/或(||)”逻辑,且支持以分号表示与逻辑,分号和逻辑符(&&、||)不支持混用。 -

不加单引号的纯数字按

jobid处理;加单引号的纯数字按JobName处理。

使用举例:

-

示例一:

按照jobid指定单个作业依赖关系

dsub -D "1=RUNNING" "echo 'hello world'"显示如下:

Submit job <2> successfully. -

示例二:

按照JobName指定依赖关系

dsub -D "job1=RUNNING" "echo 'hello world'"显示如下:

Submit job <3> successfully. -

示例三:

按照jobid指定多个作业依赖关系

dsub -D "(1=RUNNING||2=SUCCEEDED)&&3=ENDED" "echo 'hello world'"显示如下:

Submit job <4> successfully. -

示例四:

按照JobName指定依赖关系(支持通配符*)

dsub -D "job_*=SUCCEEDED" "echo 'hello world'"显示如下:

Submit job <5> successfully. -

示例五:

指定JobName包含特殊字符(特殊字符需要转义)

dsub -D "job\(202306\)=SUCCEEDED" "echo 'hello world'"显示如下:

Submit job <6> successfully. -

示例六:

指定纯数字的JobName

dsub -D "'12'=RUNNING" "echo 'hello world'"显示如下:

Submit job <7> successfully.

作业队列¶

Warning

目前已弃用使用标签对资源进行分类使用的方式,请使用队列的方式将作业提交到 arm 或 x86 节点。

为了对资源和作业进行管理,将节点分成了不同的队列,使用 dqueue 查看队列。

$ dqueue

NAME STATUS PRIORITY RUNNING_JOBS PENDING_JOBS SSTOPPED_JOBS

default OPEN,ACTIVE 1 266 2140 0

x86 OPEN,ACTIVE 1 146 143 0

AI OPEN,ACTIVE 1 0 0 0

interactive OPEN,ACTIVE 1 9 0 0

fat_x86 OPEN,ACTIVE 1 6 10 0

arm OPEN,ACTIVE 1 202 335 0

fat_arm OPEN,ACTIVE 1 30 523 0

| 队列 | 对应的节点 | 节点CPU核数 | 节点内存(GB) |

|---|---|---|---|

| arm | agent-ARM-{01-43} | 128 | 512 |

| x86 | agent-X86-{01-65} | 64 | 512 |

| AI | AI-01 | 192 | 1024 |

| fat_arm | fat-agent-ARM-{01-03} | 128 | 2048 |

| fat_x86 | fat-agent-X86-{01-03} | 64 | 2048 |

-q 选项和 -aa 选项需一起使用,否则作业无法调度至计算节点运行。

- 提交作业到普通 x86 节点,需要指定 x86 队列

#DSUB -n jobname # 指定作业名,可自定义

#DSUB -R 'cpu=2' # 每节点使用的资源,示例表示每节点使用2个cpu核心

#DSUB -o jobname_%J.out # 指定错误输出日志,%J为固定写法,表示作业ID

#DSUB -aa # 任意架构

#DSUB -q x86 # 指定 x86 队列

program # 用户自己的程序

- 提交作业到普通 arm 节点,需要指定 arm 队列

#DSUB -n jobname # 指定作业名,可自定义

#DSUB -R 'cpu=2' # 每节点使用的资源,示例表示每节点使用2个cpu核心

#DSUB -o jobname_%J.out # 指定错误输出日志,%J为固定写法,表示作业ID

#DSUB -aa # 任意架构

#DSUB -q arm # 指定 arm 队列

program # 用户自己的程序

- 提交作业到 x86 大内存节点,需要指定 fat_x86 队列

#DSUB -n jobname # 指定作业名,可自定义

#DSUB -R 'cpu=2' # 每节点使用的资源,示例表示每节点使用2个cpu核心

#DSUB -o jobname_%J.out # 指定错误输出日志,%J为固定写法,表示作业ID

#DSUB -aa # 任意架构

#DSUB -q fat_x86 # 指定 x86 队列

program # 用户自己的程序

- 提交作业到 arm 大内存节点,需要指定 fat_arm 队列

#DSUB -n jobname # 指定作业名,可自定义

#DSUB -R 'cpu=2' # 每节点使用的资源,示例表示每节点使用2个cpu核心

#DSUB -o jobname_%J.out # 指定错误输出日志,%J为固定写法,表示作业ID

#DSUB -aa # 任意架构

#DSUB -q fat_arm # 指定 arm_fat 队列

program # 用户自己的程序

内存限制¶

为了防止作业使用过多内存导致计算节点崩溃,调度系统对所有作业按核数强制限制了作业能使用内存的最大值,如 arm 队列的节点限制为每核 5GB,超过限制作业会被系统杀掉,同时日志文件内会有相关提示 Job was terminated due to reaching the mem limit, errCode: 143,如果程序需要使用 50GB 内存,则应该申请 10 个核, -R 'cpu=10' 。各节点对应的内存限制如下:

| 队列 | 节点 | 每核内存限制(GB) |

|---|---|---|

| arm | agent-ARM-{01-43} | 5 |

| x86 | agent-X86-{01-65} | 10 |

| AI | AI-01 | 10 |

| fat_x86 | fat-agent-X86-{01-03} | 32 |

| fat_arm | fat-agent-ARM-{01-03} | 16 |

dsub 其它选项¶

查看作业¶

基本使用¶

提交作业后,查看作业运行状态:djob 或 djob jobid。

$ djob

ID NAME STATE USER ACCOUNT QUEUE START_TIME END_TIME EXEC_NODES

9 gatk RUNNING usrename default default 2024/10/09 08:49:52 - agent-ARM-15

| 字段 | 含义 |

|---|---|

| ID | 作业ID |

| NAME | 作业名称,若未指定作业名称,则默认为default。 |

| STATE | 作业状态,包含WAITING、PENDING、RUNNING、STOPPED、SSTOPPED、FAILED、SUCCEEDED。 |

| USER | 提交该作业的用户名。 |

| ACCOUNT | 作业所在组织帐户。若未指定组织帐户提交或该用户未配置defaultAccount,则默认提交至default。 |

| QUEUE | 作业所在队列。若未指定队列提交或该用户未配置 defaultQueue,则默认提交至default。 |

| START_TIME | 作业开始时间。 |

| END_TIME | 作业结束时间。 |

| EXEC_NODES | 作业执行节点。 |

作业状态:

-

WAITING:调度器接收用户提交的作业,作业的初始状态是WAITING,等待调度器调度作业。 -

RUNNING:调度作业后,其状态产生两种变化:如果计算资源分配成功,作业标识为RUNNING,并分发到执行节点运行; -

PENDING:如果资源未分配成功,作业标识为PENDING,调度器将作业挂起,并发布具体原因。使用djob -l查看作业的调度详情,了解挂起原因。 -

SUCCEED:如果作业正确执行完成,标识为SUCCEED。通过查看作业输出数据了解业务计算结果。 FAILED:如果执行失败,标识为FAILED。使用djob -l查看作业的运行时详情,了解失败原因。

定制 djob 输出¶

为方便查看作业的CPU时间、内存消耗,可以改写 djob 的输出,将下面这行 alias 命令写入 ~/.bashrc 中。

alias dbs="djob --output 'jobId:8 name:8 user:8 state:8 queue:8 startTime:20 execNodes:15 totalMaxMem:15 totalUtime:15 totalStime:15'"

$ dbs

jobId name user state queue startTime execNodes totalMaxMem totalUtime totalStime

13 gatk liuhao RUNNING default 2024/10/09 11:28:57 agent-ARM-15 151168 156416 2560

作业实际 CPU 消耗¶

部分作业申请了使用多核,但由于程序本身无法充分利用多核,因此建议关注作业是否实际使用了申请的核,并以此为依据申请作业使用的核数,以免浪费核时,产生不必要的费用。

cpuUtil:值格式:avg/recent,表示作业的总CPU利用率,即从作业开始运行到最近一次采样。

-

avg:平均CPU使用率,从作业开始运行到最近一次采样的平均使用率;MPI作业为节点上该作业所有任务的平均值。 -

recent:最近一次上报的CPU使用率;

如下作业所示,当前使用了 98 核,作业从运行到目前平均使用了 9.7 核

$djob -ll jobid

...

Runtime Details:

...

nodeUsages

execNode resGroup resIndex utime stime wallclockDuration sstopedTime cpuUtil gpuUtil memResource

agent-ARM-42 0 0 200370 71784 27882 0 976/9820 - 329394/0/0/397740/397740/363698/329640

nodePids

execNode pids

agent-ARM-42 3107938

...

djob 其它选项¶

查看作业日志¶

dpeek

$ cat jobname_112345.out

TASK_INFO:

JOB_ID: 25866930

JOB_NAME: GB12

TASK_NAME: rg0.0

REPLICA: 1

TASKGROUP_NAME: rg0

SUBMIT_NODE: cli-X86-01

EXEC_NODE: agent-X86-26

EXIT_CODE: 0

EXIT_MESSAGE: Job execution succeeded

RESOURCE_USAGE_SUMMARY:

REQ_CPU: 20

REQ_MEM: 128

REQ_GPU: 0

REQ_NPU: 0

USER_CPU_TIME: 66703

SYSTEM_CPU_TIME: 550

MEMSW_MAX: 26080

SWAP_MAX: 0

MEM_MAX: 26080

MEM_AVG: 20302

MRUN_TIME: 3373

SSTOPPED_TIME: 0

CPU_UTIL_AVG(%): 1993

CPU_UTIL_RECENT(%): 1375

USER_CPU_TIME_SUM: 66703

SYSTEM_CPU_TIME_SUM: 550

MEMSW_MAX_SUM: 26080

SWAP_MAX_SUM: 0

MEM_MAX_SUM: 26080

MEM_AVG_SUM: 20302

CPU_UTIL_AVG_SUM(%): 1993

CPU_UTIL_RECENT_SUM(%): 1375

GPU_SM_UTIL_AVG(%): -

GPU_SM_UTIL_RECENT(%): -

NPU_SM_MEM_SUM(MB): -

NPU_SM_AICORE_UTIL(%): -

终止作业¶

dkill jobid 终止作业

dkill --force jobid 强制终止作业

作业控制¶

djctl stop JobID 挂起作业

djctl resume JobID 恢复作业

djctl requeue JobID 重启作业

djctl resubmit JobID 重新提交作业

修改作业资源¶

资源查看¶

节点信息¶

dnode 查看所有可用的节点及每个节点的状态、CPU、内存等资源;

| 状态 | 状态说明 |

|---|---|

| OK | 节点正常,允许关闭节点。 |

| CLOSE_ADMIN | 节点被管理员关闭,无法接收作业下发任务,允许开启节点。 |

| CLOSE_LOCK | 节点上作业批量失败,被隔离,需要管理员手动开启。 |

| CLOSE_BUSY | 节点繁忙,资源使用达到阈值,停止下发新作业,阈值下降后恢复为OK状态。 |

| CLOSE_FAULT | 节点局部故障,通信、网卡、磁盘等异常,停止下发新作业需要管理员检查处理,检测到故障解除后恢复为OK。 |

| UNAVAILABLE | 节点无法连接,或出现严重故障(共享存储故障/所有CX网卡掉线等),长期未收到节点心跳,无法接收作业下发任务,允许开启/关闭/删除节点,但是节点状态不发生变化。 |

| REGISTERING | 节点注册中,无法接收作业下发任务,不允许开启/关闭/删除节点。 |

| UNLICENSED | 在线下场景,表示系统中没有可用License文件、License文件中无计算节点资源项(CCSU-00-E01R/CCSU-00-E02R)或License文件中计算节点资源项(CCSU-00-E01R/CCSU-00-E02R)数量不足。 |

| SUSPENDED_ADMIN | 管理员手动休眠节点,无法接收作业下发任务,不允许开启/关闭/删除节点。 |

| SUSPENDED_AUTO | 节点自动进入休眠状态,可以接收作业下发任务,不允许开启/关闭/删除节点。 |

| CLOSE_EXIT | 节点即将删除状态。无法接收作业下发任务,但是正在运行的作业不受影响。该节点上的所有作业运行完成后,会自动被删除。该状态的节点仅支持强制删除操作,此时节点上的作业会被终止。 |

| CLOSE_FULL | CPU核数和GPU卡数全部分配完毕,停止下发新作业,资源释放后恢复为OK。 |

dqueue 查看集群可用的作业队列

其它¶

drun 使用不同的作业步骤(Job Step)提交不同的任务

dattach 用于支持用户直接连接作业执行节点或Docker容器

drespool 用于显示资源池信息

dacct 显示组织帐户作业统计和资源等信息

duser 用于显示用户作业统计等信息

dcluster 用于显示集群中节点、作业及队列等信息

流程软件¶

snakemake¶

v8 之前的版本

snakemake --cluster 'dsub -R "cpu={threads}"' -s Snakemake

常见故障¶

- 故障现象:作业提交后立即结束,没有日志输出

查看作业详细信息 djob -ll jobid,可以看到关键报错信息 Job execution environment build failed, err: container save failed failureHost: agent-ARM-03,大概率可能是节点的根目录写满了,请联系管理员及时处理。

查看作业详细日志

$ djob -ll 25670440

Basic Details:

jobId 25670440

name arm_STAR

state FAILED

user username

queue default

account default

cmd module load arm/stringtie/3.0.0;stringtie -p 12 -G /share/home/username/biobase/p_clarkii/pc_v2.0_ncbi_v20631_agat.gtf -o M_N_zx_1.gtf -i M_N_zx_1Aligned.sortedByCoord.q20.bam

submitNode cli-ARM-01

createTime 2025/09/03 17:31:37

startTime 2025/09/03 17:31:39

lastModifiedTime -

endTime 2025/09/03 17:31:39

currentOperation EMPTY

jobRequeueMaxCnt 0

jobRequeueCurrentCnt 0

mpiType DEFAULT

interactionMode DEFAULT

assistJob DEFAULT

x11ForwardEnabled false

description -

transferType LOCAL

forwardTime -

recallTime -

autoResize false

Scheduling Details:

exclusive false

priority 1

adminPriority -1

expectSchedTime -

startTimeEstimated -

reserveRes -

backfillRes -

backfilledRes -

Resource Details:

reqJobLicense -

allocJobLicense -

resGroup[0]:

minReplica 1

replica 1

labels arm aarch64

preferNodes -

reqNodeSelectPolicy -

effNodeSelectPolicy SEQUENCE

reqCPU 12

reqMem 128

reqGPU nvidia:0

reqNPU 0

allocCPU 12

allocMem 128

allocGPU nvidia:0

allocNPU 0

allocSdr -

reqTaskLicense -

allocTaskLicense -

limitMem 61440

allocAffinity

execNode resGroup resIndex hwThreads gpuIds npuIds

agent-ARM-03 0 0/1 - - -

Runtime Details:

execNodes agent-ARM-03

execNodeCnt 1

execPath /share/home/username/biodata/wgcna/bam_2pass

resizeCmd -

timeout 0

stderrRedirectPath /share/home/username/biodata/wgcna/bam_2pass/M_N_zx_1_star_arm_%J.err

stderrRedirectType append

stdoutRedirectPath /share/home/username/biodata/wgcna/bam_2pass/M_N_zx_1_star_arm_%J.out

stdoutRedirectType append

totalUtime 0

totalStime 0

totalMaxMemSwp 0

totalMaxMem 0

preHookRunTime 0

jobWallclockDuration 0

postHookRunTime 0

jobSstoppedTime 0

jobExitCode 0

systemExitCode 12008

exitMessage Job execution environment build failed, err: container save failed failureHost: agent-ARM-03

nodeUsages

execNode resGroup resIndex utime stime wallclockDuration sstoppedTime cpuUtil gpuUtil npuUtil memResource

agent-ARM-03 0 0/1 0 0 0 0 0/0 - - 0/0/0/0/0/0/0/0

nodePids

execNode pids

agent-ARM-03 -

traceMessages 2025/09/03 17:31:37 : [JOB_ADD] Job 25670440 is submitted by username, job state is PENDING.

2025/09/03 17:31:38 : [JOB_START] Job 25670440 start message has been sent, job state is PENDING.

2025/09/03 17:31:38 : [JOB_START_ACK] Job 25670440 start message has been received by agent agent-ARM-22.

2025/09/03 17:31:38 : [JOB_EXECUTION] Job 25670440 state is from PENDING to RUNNING.

2025/09/03 17:31:38 : [JOB_FINISH] Job 25670440 state is from RUNNING to FAILED, reason: job build failed.

2025/09/03 17:31:38 : [JOB_RETRY] Job 25670440 will retry for the 1st time, and max retry times is 1, and retry type is cluster requeue.

2025/09/03 17:31:38 : [JOB_STATE_CHANGE] Job 25670440 state is from FAILED to PENDING.

2025/09/03 17:31:39 : [JOB_START] Job 25670440 start message has been sent, job state is PENDING.

2025/09/03 17:31:39 : [JOB_START_ACK] Job 25670440 start message has been received by agent agent-ARM-03.

2025/09/03 17:31:39 : [JOB_EXECUTION] Job 25670440 state is from PENDING to RUNNING.

2025/09/03 17:31:39 : [JOB_FINISH] Job 25670440 state is from RUNNING to FAILED, reason: job build failed.

NPU 节点 (AI-01) 含 8 张 NPU 卡,卡型号为华为昇腾 910B(Ascend),单卡显存为 64GB HBM。

驱动¶

参考:

Note

集群NPU节点已安装驱动

安装固件¶

# 根据芯片型号选择相应的安装包安装

# 安装firmwire

chmod +x Ascend-hdk-*-npu-firmware_${version}.run

./Ascend-hdk-*-npu-firmware_${version}.run --full

安装驱动¶

# 根据CPU架构 以及npu型号 安装对应的 driver

chmod +x Ascend-hdk-*-npu-driver_${version}_*.run

./Ascend-hdk-*-npu-driver_${version}_*.run --full --install-for-all

npu-smi¶

npu-smi 是 npu 的系统管理工具,可以用于收集设备信息,查看设备健康状态,对设备进行配置以及执行固件升级、清除设备信息等功能。

驱动安装过程中会默认安装 npu-smi 工具。

安装完成后,npu-smi放置在 /usr/local/sbin/ 路径下。

# 查看卡基本信息及运行的进程

$ npu-smi info

# 监控卡使用信息,默认每秒刷新一次

$ npu-smi info watch

NpuID(Idx) ChipId(Idx) Pwr(W) Temp(C) AI Core(%) AI Cpu(%) Ctrl Cpu(%) Memory(%) Memory BW(%)

0 0 89.6 25 0 0 6 5 0

1 0 92.3 26 0 0 3 5 0

2 0 88.6 28 0 0 4 5 0

3 0 90.7 29 0 0 15 5 0

4 0 86.0 28 0 0 5 5 0

5 0 86.7 30 0 0 5 5 0

6 0 109.2 36 0 0 4 62 81

7 0 118.6 36 0 0 2 62 39

ascend-dmi¶

Ascend DMI(Ascend Device Management Interface)工具通过调用底层DCMI(设备控制管理接口)以及AscendCL(Ascend Computing Language,昇腾计算语言)相关接口完成相关检测功能,对于系统级别的信息查询通过调用系统提供的通用库来实现。

ascend-dmi工具主要为Atlas产品的标卡、板卡及模组类产品提供带宽测试、算力测试、功耗测试等功能。

安装

$ ./Ascend-mindx-toolbox_6.0.RC3_linux-aarch64.run --install --install-for-all --nox11

$ source /usr/local/Ascend/toolbox/set_env.sh

-

带宽测试,测试数据从Host侧传输到Device 0,迭代100次的带宽与总耗时。更多 带宽测试

# 定长模式 $ ascend-dmi --bw -t h2d -d 0 -s 8388608 --et 100 Host to Device Test Device 0: Ascend 910B3. ------------------------------------------------------------------- ID Size(Bytes) Execute Times Bandwidth(GB/s) Elapsed Time(us) ------------------------------------------------------------------- 0 8388608 100 23.566224 355.96 ------------------------------------------------------------------- -

算力测试,测试Device 2,指定算子运算类型默认为fp16,执行次数为6千万的算力。更多 算力测试

$ ascend-dmi -f -d 2 --et 60 ----------------------------------------------------------------------------------------- Device Execute Times Duration(ms) TFLOPS@FP16 Power(W) ----------------------------------------------------------------------------------------- 2 360,000,000 1988 313.531 223.300003 -----------------------------------------------------------------------------------------

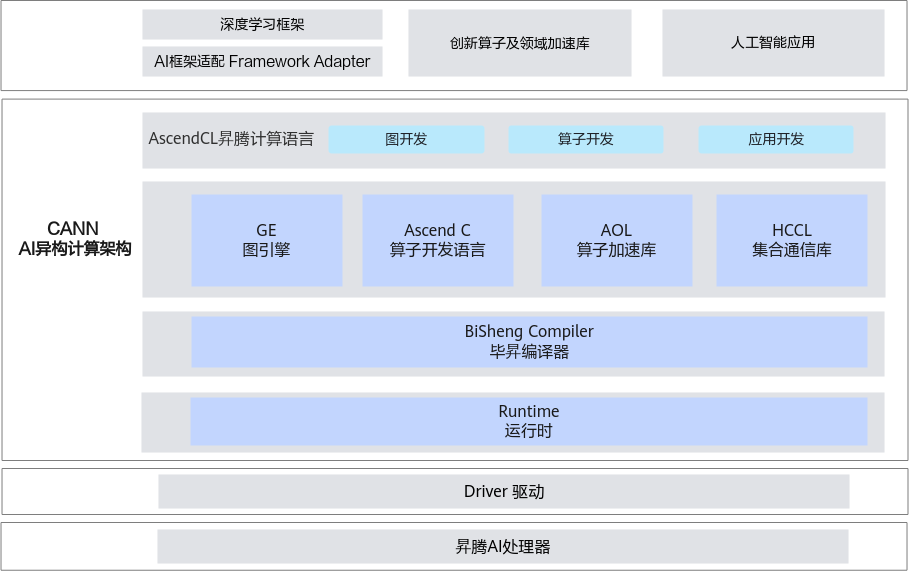

CANN¶

异构计算架构CANN(Compute Architecture for Neural Networks)是昇腾针对AI场景推出的异构计算架构,向上支持多种AI框架,包括MindSpore、PyTorch、TensorFlow等,向下服务AI处理器与编程,发挥承上启下的关键作用,是提升昇腾AI处理器计算效率的关键平台。同时针对多样化应用场景,提供多层次编程接口,支持用户快速构建基于昇腾平台的AI应用和业务。

参考

Note

集群已安装CANN

安装 toolkit¶

# 安装toolkit 以arm为例

chmod +x Ascend-cann-toolkit_${version}_linux-aarch64.run

./Ascend-cann-toolkit_${version}_linux-aarch64.run --install --install-for-all

source /usr/local/Ascend/ascend-toolkit/set_env.sh

安装 kernel¶

# 根据芯片型号选择相应的安装包安装

# 安装 kernel

chmod +x Ascend-cann-kernels-*_${version}_linux.run

./Ascend-cann-kernels-*_${version}_linux.run --install --install-for-all

pytorch for npu¶

预编译包¶

https://www.hiascend.com/document/detail/zh/Pytorch/60RC2/configandinstg/instg/insg_0001.html,这个链接中下载 torch 和 torch_npu 预编译包(whl)。

这里选择的pytorch 版本为 2.3.1,python 版本为 3.9(集群默认python版本),系统架构为 aarch64。可以根据自己的python版本、需要的pytorch版本选择对应版本的 python 包下载安装。

查看 CANN 版本 ls /usr/local/Ascend/ascend-toolkit/。

# 下载PyTorch安装包

$ wget https://download.pytorch.org/whl/cpu/torch-2.3.1-cp39-cp39-manylinux_2_17_aarch64.manylinux2014_aarch64.whl

# 下载torch_npu插件包

$ wget https://gitee.com/ascend/pytorch/releases/download/v6.0.rc2-pytorch2.3.1/torch_npu-2.3.1-cp39-cp39-manylinux_2_17_aarch64.manylinux2014_aarch64.whl

# 安装命令

$ pip3 install torch-2.3.1-cp39-cp39-manylinux_2_17_aarch64.manylinux2014_aarch64.whl

$ pip3 install torch_npu-2.3.1-cp39-cp39-manylinux_2_17_aarch64.manylinux2014_aarch64.whl

可安装的版本 https://pypi.org/project/torch-npu/#history

$ pip3 install torch_npu==2.3.1 "numpy<2.0"

import torch 出现报错 Failed to load PyTorch C extensions,可尝试设置环境变量

export LD_LIBRARY_PATH=$HOME/.local/lib/python3.9/site-packages/torch_npu/lib:$LD_LIBRARY_PATH

安装后测试 python3 -c "import torch;import torch_npu; a = torch.randn(3, 4).npu(); print(a + a);"。

自行编译 torch_npu¶

版本配套关系,这里以 v2.1.0-6.0.rc2 为例。

git clone -b v2.1.0-6.0.rc2 https://gitee.com/ascend/pytorch.git

cd pytorch

bash ci/build.sh --python=3.9

pip3 install --upgrade --upgrade dist/torch_npu-2.1.0.post7+gitunknown-cp39-cp39-linux_aarch64.whl

Warning

经测试,集群上使用预编译的 torch_npu 使用会报错,需自行编译。

使用集群预安装 torch_npu¶

$ module load arm/torch_npu/2.1.0.post7-py3.9

测试使用¶

# 交互模式进入NPU节点

$ dsub -q interactive --label AI -I bash

# 查看卡是否存在

$ lspci | grep d802

# 加载相关环境

$ source /etc/profile

$ source /usr/local/Ascend/ascend-toolkit/set_env.sh

# 查看卡信息

$ npu-smi info

# 测试 pytorch 安装是否正常

$ python3 -c "import torch;import torch_npu;print(torch_npu.npu.is_available())"

# 测试使用 torch 运算,如果出现下面的运算结果,表明 pytorch 框架与插件安装成功

$ python3 -c "import torch;import torch_npu; a = torch.randn(3, 4).npu(); print(a + a);"

tensor([[-0.6066, 6.3385, 0.0379, 3.3356],

[ 2.9243, 3.3134, -1.5465, 0.1916],

[-2.1807, 0.2008, -1.1431, 2.1523]], device='npu:0')

参考

代码迁移¶

已有的基于英伟达 cuda 的 pytorch 代码可以通过更改少量的代码迁移到 npu 上运行,相关方法见:

考试内容¶

集群用户考核内容给分为三块:

- Linux基本使用

- 多瑙调度器使用

- 规章制度和注意事项

Linux基本使用¶

- 文件目录操作,要求掌握文件所属的用户和用户组、文件权限的概念(可读、可写、可执行),理解不同的文件类型,如普通文件、目录、块设备、链接文件等,要求掌握的命令

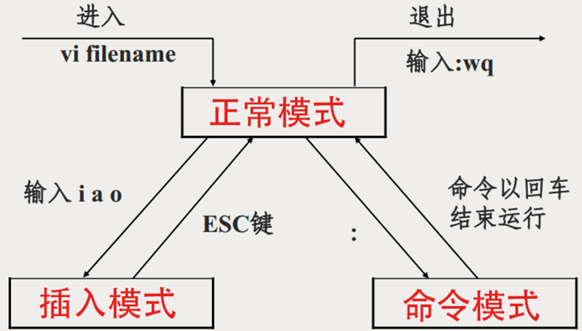

ls、pwd、cd、mv、rm、mkdir、ln、cp、chmod、alias; - 文本操作,需要掌握至少一种文本编辑器(推荐vim),理解管道、重定向,要求掌握基本的文本处理命令

cat、more、less、head、tail、wc、nl、cut、sort、uniq、grep、sed、awk、file; - 查看系统信息,能使用Linux系统提供的工具和命令查看磁盘使用、系统负载、内存使用、系统版本等信息,需要掌握的命令

df、du、free、uptime; - 进程管理,了解进程和多线程的基本概念,需要掌握的命令

top、ps、bg、fg、jobs、kill、pgrep、nohup、screen、Ctrl+z、Ctrl+c;

- 简单的Linux shellscprit编程知识,掌握基本的语法;

- 其他,文件查找

which、locate、find、where,文件压缩tar、gzip、pigz,查看帮助文档man,远程文件传输scp rsync,不同节点间跳转ssh,查看已使用的命令history,查看当前登陆用户who,文件下载wget,windows文件转Unix文件dos2unix。

linux学习可以参考:Linux 基础

多瑙调度器使用¶

规章制度和注意事项¶

Ended: 平台使用

应用软件 ↵

module¶

MODULEPATH 配置,在个人账号 ~/.bashrc 文件中,写入下面两行代码,执行 source ~/.bashrc 生效。

export MODULEPATH="/share/software/modulefiles/:/share/software/HPCKit/latest/modulefiles:$MODULEPATH"

export appdir="/share/software/app/"

$ module av

---------------------------------------------------------- /share/software/modulefiles ----------------------------------------------------------

arm/automake/1.13 arm/cmake/3.30.5 arm/hisat2/2.1.0 arm/minimap2/2.28 arm/star/2.7.11b x86/hifiasm/0.19.9

arm/automake/1.14 arm/curl/8.10.1 arm/htslib/1.21 arm/ncbi-vdb/3.1.1 arm/tassel/5 x86/hisat2/2.1.0

arm/bcftools/1.21 arm/fastp/0.23.4 arm/isal/2.30.0 arm/nextdenovo/2.5.2 arm/vg/1.60.0 x86/htslib/1.21

arm/bedtools/2.31.1 arm/fastqc/0.12.1 arm/java/17.0.11 arm/openblas/0.3.28 arm/zlib/1.3 x86/java/21.0.2

arm/blast/2.16.0 arm/fasttree/2.1.11 arm/jellyfish/2.3.1 arm/openssl/3.3.2 arm/zstd/1.5.6 x86/megahit/1.2.9

arm/boost/1.86.0 arm/gatk/4.6.0.0 arm/libdeflate/1.8 arm/pangenie/3.1.0 x86/bwa/0.7.18 x86/minimap2/2.28

arm/bowtie2/2.5.4 arm/gcc/12.2.0 arm/libpsl/0.21.5 arm/r/4.4.1 x86/bzip2/1.0.6 x86/samtools/1.21

arm/bwa/0.7.18 arm/gsl/2.8 arm/maven/3.9.9 arm/samtools/1.21 x86/cellranger/7.0.0 x86/star/2.7.11b

arm/clapack/3.2.1 arm/hifiasm/0.19.9 arm/megahit/1.2.9 arm/sratools/3.1.1 x86/gatk/4.6.0.0 x86/vg/1.60.0

-------------------------------------------------------- /usr/share/Modules/modulefiles ---------------------------------------------------------

dot module-git module-info modules null use.own

Key:

modulepath

module 更详细的用法见 module 使用。

$ module load arm/bwa/0.7.18

$ bwa

Program: bwa (alignment via Burrows-Wheeler transformation)

Version: 0.7.18-r1243-dirty

Contact: Heng Li <hli@ds.dfci.harvard.edu>

Usage: bwa <command> [options]

Command: index index sequences in the FASTA format

mem BWA-MEM algorithm

fastmap identify super-maximal exact matches

pemerge merge overlapping paired ends (EXPERIMENTAL)

aln gapped/ungapped alignment

samse generate alignment (single ended)

sampe generate alignment (paired ended)

bwasw BWA-SW for long queries (DEPRECATED)

shm manage indices in shared memory

fa2pac convert FASTA to PAC format

pac2bwt generate BWT from PAC

pac2bwtgen alternative algorithm for generating BWT

bwtupdate update .bwt to the new format

bwt2sa generate SA from BWT and Occ

Note: To use BWA, you need to first index the genome with `bwa index'.

There are three alignment algorithms in BWA: `mem', `bwasw', and

`aln/samse/sampe'. If you are not sure which to use, try `bwa mem'

first. Please `man ./bwa.1' for the manual.

Singularity 镜像¶

集群公共目录 /share/software/image/arm/ 目录下放了一些在 arm 上打包好的 Singularity 镜像,可以直接调用。注意,arm 镜像不可在 x86 节点上使用。

Singularity 更详细的用法见 Singularity使用。

$ module load arm/singularity/4.1.5

$ singularity exec /share/software/image/arm/bwa-0.7.18.sif bwa

Program: bwa (alignment via Burrows-Wheeler transformation)

Version: 0.7.18-r1243-dirty

Contact: Heng Li <hli@ds.dfci.harvard.edu>

Usage: bwa <command> [options]

Command: index index sequences in the FASTA format

mem BWA-MEM algorithm

fastmap identify super-maximal exact matches

pemerge merge overlapping paired ends (EXPERIMENTAL)

aln gapped/ungapped alignment

samse generate alignment (single ended)

sampe generate alignment (paired ended)

bwasw BWA-SW for long queries (DEPRECATED)

shm manage indices in shared memory

fa2pac convert FASTA to PAC format

pac2bwt generate BWT from PAC

pac2bwtgen alternative algorithm for generating BWT

bwtupdate update .bwt to the new format

bwt2sa generate SA from BWT and Occ

Note: To use BWA, you need to first index the genome with `bwa index'.

There are three alignment algorithms in BWA: `mem', `bwasw', and

`aln/samse/sampe'. If you are not sure which to use, try `bwa mem'

first. Please `man ./bwa.1' for the manual.

说明¶

- 各种脚本、jar包、编译好的二进制可执行包, e.g. NCBI直接下载编译好的blast

- 采用C/C++等编写, 只有源码,按文档要求编译, e.g. 下载R源码, 自己编译安装

- 系统自带的包管理器(需root权限)

- bioconda, 生信软件包管理器

- docker、singularity容器镜像

- Python、perl、R等的模块或包

环境变量¶

PATH, 自动搜索安装的可执行文件

LD_LIBRARY_PATH,动态链接库搜索位置

PERL5LIB,perl模块位置

PYTHONPATH,python模块位置

export PATH=/opt/bin/:$PATH #或写入~/.bashrc文件

脚本软件¶

采用Perl/Python等解释型语言编写, 下载后有解释器即可运行。

用法:系统安装对应的解释器, 添加x权限

优点:下载就可以直接用, 修改方便

缺点:可能需要很多依赖, 性能差

$ mv N50.pl ~/opt/bin/

$ export PATH="$PATH:$HOME/opt/bin/" #或写入~/.bashrc文件

jar包¶

采用java或类java语言编写, 开发人员已编译打包好, 下载可用。

用法:系统安装java运行环境JDK, java -jar package.jar

优点:下载就可以直接用, 跨平台

缺点: 相比C/C++性能较差, 对内存有一定要求

$ cd ~/opt

$ wget http://www.usadellab.org/cms/uploads/supplementary/Trimmomatic/Trimmomatic-0.39.zip

$ unzip Trimmomatic-0.39.zip

$ java -jar trimmomatic-0.36.jar PE \

-phred33 input_forward.fq.gz input_reverse.fq.gz \

output_forward_paired.fq.gz output_forward_unpaired.fq.gz \

output_reverse_paired.fq.gz output_reverse_unpaired.fq.gz \

ILLUMINACLIP:/usr/local/src/Trimmomatic/Trimmomatic-0.36/adapters/TruSeq3-PE.fa:2:30:10 \

LEADING:3 TRAILING:3 SLIDINGWINDOW:4:15 HEADCROP:8 MINLEN:36

二进制可执行包¶

采用C/C++等编译语言编写, 开发人员已编译好, 下载可用

用法:下载系统对应版本的二进制软件, 添加x权限

优点:下载就可以直接用, 不依赖编译器

缺点:没法看到源码;不能根据需要预编译;依赖预编译系统的底层库; 跨平台性差

$ cd ~/opt

$ mkdir sratoolkit && cd sratoolkit

$ wget http://ftp-trace.ncbi.nlm.nih.gov/sra/sdk/2.6.3/sratoolkit.2.6.3-centos_linux64.tar.gz

$ tar zxvf sratoolkit.2.6.3-centos_linux64.tar.gz

$ chmod +x ~/opt/sratoolkit/sratoolkit.2.6.3-centos_linux64/bin/*

$ ~/opt/sratoolkit/sratoolkit.2.6.3-centos_linux64/bin/fastdump -h

源码编译¶

采用C/C++等编译语言编写, 开发人员提供源代码以及安装文档, 用户根据平台自行编译

用法: 安装好编译器以及依赖库,按文档要求编译

优点: 可以指定预编译选项;使用自己系统的依赖库

缺点: 对新手不友好; 很多软件编译步骤复杂; 自己手动解决依赖;

常用编译器¶

GCC(GNU Compiler Collection,GNU编译器套件)

- 由GNU开发的编程语言编译器,是采用GPL及LGPL协议所发行的自由软件,是Linux及类Unix标准编译器,被认为是跨平台编译器的事实标准

- GCC可处理C、C++、Fortran、Pascal、Objective-C、Java等其他语言

Intel Composer XE (ntel 编译器)

- Intel编译器是Intel公司发布的x86平台(IA32/INTEL64/IA64/MIC)编译器产品,支持C/C++/Fortran编程语言

- Intel编译器针对Intel处理器进行了专门优化,性能优异,在其它x86处理器平台上表现同样出色

LLVM (Low Level Virtual Machine,底层虚拟机)

- Apple资助开发的编译器,支持C、C++、Objective-C和Objective-C++

- 编译速度快;占用内存小;模块化设计,易与IDE集成及其他用途重用;诊断信息可读性强,有利于调试

源代码后缀规范¶

在Linux系统中,可执行文件没有统一的后缀,系统从文件的属性来区分。而源代码、目标文件等后缀名最好保持统一的规范,便于识别区分。

| 文件类型 | 后缀名 |

|---|---|

| C source | .c |

| C++ source | .C, .cc, .cpp, .cxx, .c++ |

| Fortran77 source | .f, .for |

| Fortran90/95 source | .f90 |

| 汇编source | .s |

| 目标文件 | .o |

| 头文件 | .h |

| Fortran90/95模块文件 | .mod |

| 动态链接库 | .so |

| 静态链接库 | .a |

c语言编译¶

# 编译时,指定生成可执行文件的路径或文件名(-o参数)

$ gcc -o hello hello.c

$ file hello

hello: ELF 64-bit LSB executable, x86-64, version 1 (SYSV),

for GNU/Linux 2.6.4, dynamically linked (uses shared libs), not stripped

$ gcc -o /home/test/hello hello.c

#include <stdio.h>

int main()

{

printf("Hello world.\n");

}

#多个源文件同时编译,生成可执行文件sum

$ gcc -o sum main.c function.c

# 源文件分别编译,再将目标文件连接成可执行文件

$ gcc -c main.c

$ gcc -c function.c

$ gcc -o sum main.o function.o

#include <stdio.h>

int main()

{

int sum=0,r,i;

for(i=1;i<=10;i++)

{

r=function(i);

sum=sum+r;

}

printf("sum is %d\n",sum);

}

int function(int x)

{

int result;

result=x*x; return(result);

}

Makefile¶

源文件数量非常多、存放在不同目录下、相互之间有各种依赖关系以及先后顺序关系时,需要使用Makefile进行管理。Makefile定义了一系列的规则来指定哪些文件需要先编译,哪些文件需要后编译,哪些文件需要重新编译,甚至于进行更复杂的功能操作。

- 软件程序的管理工具

- 定义规则,实现自动化编译

- 处理源代码、目标文件、头文件、库文件等依赖关系

- 根据规则和依赖关系,结合时间戳实现精细化控制

make命令执行 Makefile 中的定义的编译流程。make命令默认读取当前目录 Makefile 或 makefile 文件,也可以用 -f 参数指定 Makefile 文件

configure¶

autotool生成configure文件, 有程序不提供configure, 提供autogen.sh

Makefile.am和makefile.in生成Makefile

大型开源程序通常使用configure脚本生成Makefile,Configure脚本作用:

- 检查编译环境 (数据类型长度(int),操作系统,CPU平台)

- 检查依赖头文件及库文件

- 设置安装路径

- 设置编译器及编译参数

configure → make → make install

Configure常用参数:

- --prefix=/opt/software 指定安装路径

- -h 查看configure帮助,configure支持选项

- CC=gcc/icc 设置c语言编译器

- CFLAGS=-O2 –funrool- c编译器参数

- CXX=g++/icpc 设置c++编译器

- CXXFLAGS=-O2 c++编译器参数

- FC=gfortran/ifort 设置fortran编译器

- FCFLAGS=-O2 fortran编译器参数

- --with-XXX 编译时使用XXX包

- --without-XXX 编译时不使用XXX包

- --enable-XXX 启用XXX特性

- --disable-XXX 不启用XXX特性

编译安装samtools

$ wget https://github.com/samtools/samtools/releases/download/1.3.1/samtools-1.3.1.tar.bz2

$ tar xvfj samtools-1.3.1.tar.bz2

$ cd samtools-1.3.1

$ ./configure –prefix=/home/username/opt/samtools/1.3.1

$ make

$ make install

$ echo "export PATH=/home/username/opt/samtools/1.3.1:$PATH" >> ~/.bashrc

cmake¶

cmake:跨平台编译工具,生成makefile。其配置文件为CMakeLists.txt。

cmake → make → make install

cmake常用参数:

- -DCMAKE_INSTALL_PREFIX=/opt/software 指定安装路径

- -DCMAKE_C_COMPILER=/opt/gcc/bin/gcc 设置c语言编译器

- -DCMAKE_CXX_FLAGS ="-O2 –funrool-" c编译器参数

- -DCMAKE_CXX_COMPILER = =/opt/gcc/bin/gcc 设置c++编译器

也可以使用CC CXX 指定gcc

$ export CC=$HOME/opt/gcc/9.4/bin/gcc

$ export CXX=$HOME/opt/gcc/9.4/bin/g++

$ tar –xf gromacs-5.1.4.tar.gz

$ cd gromacs-5.1.5

$ mkdir build && cd build

$ cmake ..

$ make –j 20

$ make install

系统包管理器¶

用法:不同的操作系统用法不大一样 yum: RedHat, CentOS, Fedora; apt-get: Ubuntu, Debian; brew:MacOS

优点:简单, 一键搞定;包管理器自己解决软件依赖

缺点:生物信息软件大部分不在包管理器中, 用于安装底层依赖库;需要root权限

# ubuntu

sudo apt-get -y install libcurl4-gnutls-dev

sudo apt-get -y install libxml2-dev

sudo apt-get -y install libssl-dev

sudo apt-get -y install libmariadb-client-lgpl-dev

# centos

$ yum search openssl

$ yum install -y openssl-devel

conda¶

Anaconda 用于科学计算Python发行版,使用conda 管理包和环境。conda 不仅管理安装python包,还可以是各种其他的应用软件。

优点:不需要root权限;自行解决依赖关系;一键安装, 不需要配置环境

缺点:有些软件conda中没有, 需要自己手动安装;环境混乱、版本管理麻烦

Note

conda 安装软件较慢,可以使用mamba代替,使用方式与conda一直。其配置使用见集群文档 mamba。

配置¶

# 第一步:下载miniconda3

$ wget https://nanomirrors.tuna.tsinghua.edu.cn/anaconda/miniconda/Miniconda3-latest-Linux-$(uname -m).sh

# 第二步:安装miniconda3

$ bash Miniconda3-latest-Linux-x86_64.sh -b -p $HOME/miniconda3

# 第三步:将miniconda3保存到环境路径并启用

$ echo "export PATH=$PREFIX/bin:"'$PATH' >> ~/.bashrc

$ source ~/.bashrc

#第四步:基本配置bioconda,添加清华源镜像

$ conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free

$ conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/conda-forge

$ conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/bioconda

$ conda config --set show_channel_urls yes

管理软件包¶

# 搜索需要安装的软件包,获取其完成名字

conda search <package name>

# 安装软件包

conda install <package name>

# 安装特定版本的软件包

conda install <package name>=版本号

# 更新软件包

conda update <package name>

# 移除软件包

conda remove <package name>

# 安装R,及80多个常用的数据分析包, 包括idplyr, shiny, ggplot2, tidyr, caret 和 nnet

conda install -c r r-essentials

管理环境¶

通过conda环境,可以实现软件版本管理、流程环境管理。

# 创建名为env_name的新环境,并在该环境下安装名为 package_name 的包

$ conda create -n env_name package_name

# 可以指定新环境的版本号,例如:创建python2环境,python版本为2.7,同时还安装了numpy pandas包

$ conda create -n python2 python=2 numpy pandas

# 激活 python2环境,通过python -V可以看到是python2.7

$ conda activate python2

# python2 环境中安装相关包

$ conda install pandas

# 退出 python2 环境

$ conda deactivate

# 删除环境

$ conda remove -n env_name --all

# 查看当前存在的虚拟环境

$ conda env list

$ conda info -e

直接使用bioconda内的软件¶

部分编译比较复杂的软件,可以在bioconda内找到该软件,然后点击"Files",在里面下载编译好的软件,执行时如果有库缺失、GCC版本不够的报错,可以载入相应的库和GCC,此方式可以快速安装复杂软件。

docker¶

操作系统之上的虚拟层,提供独立于系统的软件环境;兴起于互联网行业,便于项目开发和交付部署,提高硬件资源利用率。

优点: 简单,对于复杂软件可以一键安装;无需安装任何依赖

缺点: 无法与作业调度软件结合使用;权限要求较高,多用户使用有风险

docker pull quay.io/qiime2/core:2021.8

singularity¶

HPC集群的容器工具,直接使用docker镜像。使用singularity搭建分析流程,可以在所有机器上运行。

优点: 简单;无需安装任何依赖;安全;可结合作业调度系统;高性能;适应性广

缺点: 软件较少;文件比较大

# 从给定的URL下载容器镜像,常用的有URL有Docker Hub(docker://user/image:tag) 和 Singularity Hub(shub://user/image:tag)

$ singularity pull tensorflow.sif docker://tensorflow/tensorflow:latest

# 在容器中执行某个命令

$ singularity exec /share/Singularity/saige_0.35.8.2.sif

# 进入容器

$ singularity shell /share/Singularity/ubuntu.sif

R包安装¶

# 从官方源安装,最常见方式

$ >install.packages("ggplot2")

# 同时安装多个包

$ >install.packages(c("broom", "clusterProfiler", "dorothea", "DOSE", "dplyr"))

# 指定安装源和安装路径

$ >install.packages("ggplot2", repos = "https://mirrors.ustc.edu.cn/CRAN/",lib="~/opt/Rlib")

# 使用Rscript,方便安装包报错时试错,不用每次进入R交互界面,然后又退出

$ Rscript -e 'install.packages(c("RcppArmadillo"), repos="https://mirrors.ustc.edu.cn/CRAN/")'

# 源码安装

$ R CMD INSTALL /path/rpackage.tar.gz

# 或

$ >install.packages("/path/rpackage.tar.gz", repos = NULL, type = "source")

# 安装指定版本的R包

$ >require(devtools)

$ >install_version("limma", version = "1.8.0")

# 或

$ >install.packages("https://cran.r-project.org/src/contrib/Archive/limma/limma_1.8.10.tar.gz", repos=NULL, type="source")

# bioconductor包安装

$ >install.packages("BiocManager")

$ >BiocManager::install("clusterProfiler")

# 指定安装位置和源

$ >options(BioC_mirror="https://mirrors.tuna.tsinghua.edu.cn/bioconductor")

$ >.libPaths(c("~/R/4.2/", .libPaths()))

$ >BiocManager::install("clusterProfiler")

# 也可以使用Rscript

$ Rscript -e 'BiocManager::install("clusterProfiler")'

https://bioconductor.org/packages/3.19/BiocViews.html#___Software

https://bioconductor.org/packages/3.19/bioc/html/XVector.html

# 测试包是否正常安装

$ >library(package)

# 其它包常见操作

# 卸载包

$ >remove.packages("package")

# 更新包

$ >update.packages("package")

# 查看R包安装位置

$ >.libPaths()

# 查看已安装包

$ >installed.packages()

# 查看包版本

$ >packageVersion("package")

# 查看包安装位置

$ >find.package("package")

$ >install.packages("pak")

$ >library(pak)

# 安装CRAN中的包

$ >pak:pak("ggplot2")

# 指定安装路径

$ >pak:pak("ggplot2", lib="PATH")

# 安装Bioconductor中的包

$ >pak::pak("clusterProfiler")

# 安装github上的包

$ >pak::pak("lchiffon/REmap")

# 使用URL

$ >pak::pkg("url::https://cran.r-project.org/src/contrib/Archive/tibble/tibble_3.1.7.tar.gz")

# 本地安装

# shell

$ wget https://cytotrace.stanford.edu/CytoTRACE_0.3.3.tar.gz

# 解压后为CytoTRACE

$ tar -xf CytoTRACE_0.3.3.tar.gz

# R

$ >pak::local_install("CytoTRACE")

# 或

$ >pkg_install("local::./CytoTRACE_0.3.3.tar.gz")

# 安装多个包

$ >pak::pkg(c("BiocNeighbors", "ComplexHeatmap", "circlize", "NMF"))

# 更新包

$ >pak::pkg_install("tibble")

# 更新包的所有依赖,默认不更新依赖

$ >pak::pkg("tibble", upgrade = TRUE)

# 重装包

$ >pak::pkg_install("tibble?reinstall")

# 卸载包

$ >pkg_remove("tibble")

perl包安装¶

# CPAN 模块自动安装

# 如果使用系统的cpan,则需要root权限,因此普通用户建议使用cpanm代替

$ cpan -i Bio::SeqIO

# cpanm 推荐

$ wget https://cpanmin.us -O capnm

$ cpanm --mirror http://mirrors.163.com/cpan --mirror-only Bio::SeqIO

# cpanm 指定安装目录

$ cpanm --mirror http://mirrors.163.com/cpan --mirror-only -l /path/to/perl/5.34.0/ Bio::SeqIO

# 源码安装

$ tar xvzf BioPerl-1.7.5.tar.gz

$ cd BioPerl-1.7.5

$ perl Makefile.PL (PREFIX=/home/opt/perl_modules)

$ make && make install

# 添加环境变量

$ export PERL5LIB=$PERL5LIB:/home/opt/perl_modules/lib/site_perl #或者把该行内容添加到 ~/.bashrc

# 测试perl模块安装正常

$ perl -MBio::SeqIO -e1 或 perldoc Bio::SeqIO

#如下报错,可能是perl版本冲突导致,即安装perl包的版本和使用perl包的版本不一致,建议将~/.bashrc perl相关的部分注释,然后再测试

perl: symbol lookup error: perl5/lib/perl5/x86_64-linux-thread-multi/auto/Cwd/Cwd.so: undefined symbol

python包安装¶

python 源码编译

其中 --enable-loadable-sqlite-extensions 的作用是防止部分应用使用 sqlite3 包时出现报错 No module named '_sqlite3',需要系统安装有 sqlite-devel。

$ tar xf Python-3.11.10.tgz

$ cd Python-3.11.10

$ ./configure --enable-optimizations --enable-loadable-sqlite-extensions --prefix=/path/to/python/

$ make -j20 && make install

# conda

$ conda install biopython

# pip

$ pip install --prefix=/home/opt/ppython_modules/ biopython 或 pip install --user biopython

# 使用国内源

$ pip install --prefix=/home/opt/ppython_modules/ -i https://pypi.tuna.tsinghua.edu.cn/simple biopython

# requirements.txt文件

$ pip install -r requirements.txt --prefix=/home/opt/ppython_modules/

# 源码

$ git clone https://github.com/madmaze/pytesseract.git

$ python setup.py install --prefix=/home/opt/ppython_modules或 pip install . --prefix=$PREFIX_PATH

# 测试python模块安装正常

$ python -c "import Bio"

# 添加环境变量

$ export PYTHONPATH=$PREFIX_PATH:/home/opt/python_modules/lib/python2.7/site-packages/ #或者加到 ~/.bashrc

常用包的所有 whl 文件 https://pypi.tuna.tsinghua.edu.cn/simple/numpy/

centos7中高版本的python,使用pip安装包时可能出现报错 pip is configured with locations that require TLS/SSL, however the ssl module in Python is not available,最快捷的解决办法为:

$ pip3 install pymysql -i http://mirrors.aliyun.com/pypi/simple --trusted-host mirrors.aliyun.com

注意事项¶

-

生信绝大部分软件都可以使用普通用户安装,不需要root权限。普通用户无法在集群上使用yum apt等安装软件;

-

软件安装过程中出现libxx库文件缺失的问题,一般都可以找到相应的源码,编译安装,设置环境变量即可;

-

避免使用conda一键安装软件,时间长了会导致各种环境问题,直至所有软件不可用,推到重来;

-

软件安装或使用过程中出现问题,最好将~/.bashrc中无关部分都临时注释掉,避免其它软件的影响;

-

使用软件前看一下集群公共软件库,尽量使用公共软件,一个软件一个环境,出现问题比较好排查;

介绍¶

毕昇编译器是华为编译器实验室针对鲲鹏等通用处理器架构场景,打造的一款高性能、高可信及易扩展的编译器工具链,增强和引入了多种编译优化技术,支持C/C++/Fortran等编程语言及对应编程语言的OpenMP扩展。

华为高性能通信库(Hyper MPI,hmpi)是整个高性能计算解决方案的关键组件,它实现了并行计算的网络通讯功能,可以用来支持制造、气象、分子动力学等应用场景。

集群上配置了华为毕昇编译器以及Hyper MPI,使用以下命令加载。

module purge

source /share/software/HPCKit/latest/setvars.sh

module use /share/software/HPCKit/latest/modulefiles

module load bisheng/compiler/bishengmodule bisheng/hmpi/hmpi

或

module load arm/hyper-mpi/24.6.30_bisheng

$ mpicc -show

clang -I/share/software/HPCKit/24.6.30/hmpi/bisheng/hmpi/include -I/share/software/HPCKit/24.6.30/hmpi/bisheng/hmpi/include/openmpi -I/share/software/HPCKit/24.6.30/hmpi/bisheng/hmpi/include/openmpi/opal/mca/hwloc/hwloc201/hwloc/include -I/share/software/HPCKit/24.6.30/hmpi/bisheng/hmpi/include/openmpi/opal/mca/event/libevent2022/libevent -I/share/software/HPCKit/24.6.30/hmpi/bisheng/hmpi/include/openmpi/opal/mca/event/libevent2022/libevent/include -L/share/software/HPCKit/24.6.30/hmpi/bisheng/hmpi/lib -Wl,-rpath -Wl,/share/software/HPCKit/24.6.30/hmpi/bisheng/hmpi/lib -Wl,--enable-new-dtags -lmpi

编译 lammps¶

这里以 lammps 编译安装为例,介绍毕昇编译器以及Hyper MPI的使用。

加载编译环境¶

module load arm/hyper-mpi/24.6.30_bisheng

编译配置 fftw¶

安装 fftw,样例安装目录:/path/to/FFTW

wget http://www.fftw.org/fftw-3.3.8.tar.gz

tar -xvf fftw-3.3.8.tar.gz

cd fftw-3.3.8

export CC=`which clang`

export CXX=`which clang++`

export FC=`which flang`

./configure --prefix=/path/to/FFTW --enable-shared --enable-static --enable-fma --enable-neon

make -j 96

make install

配置fftw环境变量

export PATH=/path/to/FFTW/bin:$PATH

export LD_LIBRARY_PATH=/path/to/FFTW/lib:$LD_LIBRARY_PATH

编译 lammps¶

下载lammps源码包:https://www.lammps.org/download.html

tar -xzf lammps-stable.tar.gz

cd lammps-29Aug2024/src

MAKE/Makefile.mpi 文件,修改CCFLAGS、LINKFLAGS、FFT_INC、FFT_PATH、FFT_LIB 这5行的内容:

CC = mpicxx

CCFLAGS = -g -O3 -I/path/to/BISHENG/include/c++/v1 -L/path/to/BISHENG/lib -std=c++11 -stdlib=libc++ -lc++ -lc++abi

SHFLAGS = -fPIC

DEPFLAGS = -M

LINK = mpicxx

LINKFLAGS = -g -O -L/path/to/BISHENG/lib -std=c++11 -stdlib=libc++ -lc++ -lc++abi

LIB =

SIZE = size

……

ARCHIVE = ar

ARFLAGS = -rc

SHLIBFLAGS = -shared

FFT_INC = -DFFT_FFTW -I/path/to/FFTW/include

FFT_PATH = -L/path/to/FFTW/lib

FFT_LIB = -lfftw3

make yes-KSPACE

make yes-MPIIO

make yes-MOLECULE

make yes-MANYBODY

make mpi -j

编译 lapack¶

加载编译环境¶

module load arm/hyper-mpi/24.6.30_bisheng

编译 lapack¶

tar xf lapack-3.12.0.tar.gz

cd lapack-3.12.0

cp INSTALL/make.inc.gfortran make.inc

将 make.inc 中的 CC = gcc 改为 CC = clang,FC = gfortran 改为 FC = flang。

TIMER = INT_ETIME 注释掉,# TIMER = INT_CPU_TIME 取消注释,否则编译报错 etime is not an intrinsic function。

修改后的 make.inc 如下所示。

####################################################################

# LAPACK make include file. #

####################################################################

SHELL = /bin/sh

# CC is the C compiler, normally invoked with options CFLAGS.

#

CC = clang

CFLAGS = -O3

# Modify the FC and FFLAGS definitions to the desired compiler

# and desired compiler options for your machine. NOOPT refers to

# the compiler options desired when NO OPTIMIZATION is selected.

#

# Note: During a regular execution, LAPACK might create NaN and Inf

# and handle these quantities appropriately. As a consequence, one

# should not compile LAPACK with flags such as -ffpe-trap=overflow.

#

FC = flang

FFLAGS = -O2 -frecursive

FFLAGS_DRV = $(FFLAGS)

FFLAGS_NOOPT = -O0 -frecursive

# Define LDFLAGS to the desired linker options for your machine.

#

LDFLAGS =

# The archiver and the flag(s) to use when building an archive

# (library). If your system has no ranlib, set RANLIB = echo.

#

AR = ar

ARFLAGS = cr

RANLIB = ranlib

# Timer for the SECOND and DSECND routines

#

# Default: SECOND and DSECND will use a call to the

# EXTERNAL FUNCTION ETIME

#TIMER = EXT_ETIME

# For RS6K: SECOND and DSECND will use a call to the

# EXTERNAL FUNCTION ETIME_

#TIMER = EXT_ETIME_

# For gfortran compiler: SECOND and DSECND will use a call to the

# INTERNAL FUNCTION ETIME

#TIMER = INT_ETIME

# If your Fortran compiler does not provide etime (like Nag Fortran

# Compiler, etc...) SECOND and DSECND will use a call to the

# INTERNAL FUNCTION CPU_TIME

TIMER = INT_CPU_TIME

# If none of these work, you can use the NONE value.

# In that case, SECOND and DSECND will always return 0.

#TIMER = NONE

...

BLASLIB = $(TOPSRCDIR)/librefblas.a

CBLASLIB = $(TOPSRCDIR)/libcblas.a

LAPACKLIB = $(TOPSRCDIR)/liblapack.a

TMGLIB = $(TOPSRCDIR)/libtmglib.a

LAPACKELIB = $(TOPSRCDIR)/liblapacke.a

# DOCUMENTATION DIRECTORY

# If you generate html pages (make html), documentation will be placed in $(DOCSDIR)/explore-html

# If you generate man pages (make man), documentation will be placed in $(DOCSDIR)/man

DOCSDIR = $(TOPSRCDIR)/DOCS

编译 make -j20 lapacklib。

如编译有报错,修改后 make clean再编译。

参考

x86移植到鲲鹏常见编译脚本、编译选项移植、builtin函数、内联汇编函数替换汇总

在GCC 9.1.0版本,支持了鲲鹏处理器所兼容的ARM v8指令集、TaiShan v110流水线。

使用方法:

在GCC for openEuler编译器、毕昇编译器、GCC编译器高于9.1.0版本上,并在CFLAGS、CPPFLAGS里增加编译选项:

-mtune=tsv110 -march=armv8-a

https://hpc.ilri.cgiar.org/list-of-software

http://ftp.genek.cn:8888/Share/linux_software/

常见报错¶

-

c++: error: unrecognized command-line option ‘-mbmi2’`-mbmi2` 是一个 GCC 编译器的命令行选项,用于启用针对支持 BMI2(Bit Manipulation Instruction Set 2)的处理器架构的优化。BMI2 是 Intel 和 AMD 处理器的一组指令集扩展,旨在提高位操作的性能。 解决:移除该编译选项 -

c++: error: unrecognized command-line option ‘-mpopcnt’-mpopcnt 是 GCC 编译器的一个选项,用于启用对 POPCNT 指令的支持。POPCNT 是一种位操作指令,用于快速计算一个二进制数中“1”的个数,通常可用于优化与位操作相关的算法。 解决:移除该编译选项

公共软件安装规范¶

-

慎用 root 安装各类依赖库、python 包、perl 模块等,以免导致各节点环境不一致、环境混乱,也没法做版本管理。root 非必要不使用。

-

zlib、gsl、zstd、xz、hdf5等各类依赖均使可使用普通账号源码编译,然后写好modulefile,使用时module载入即可。 -

公共环境禁止使用

conda安装任何软件,如果无法避免,则在singularity镜像中使用conda安装所需的软件,用户调用该镜像即可。 -

perl 所需的模块可以安装在 module 的 perl 中,基准版本为

arm/perl/5.34.0。 -

R 包可以安装在 module 的 R 中,基本版本为

arm/r/4.4.1。 -

由于 python 包更新频繁、各个软件依赖的 python 版本区别较大,因此每个应用软件依赖的 python 包均应该安装在该软件目录内(使用

--prefix指定安装目录),而不是在系统或公共 python 目录内,modulefile文件中使用PYTHONPATH环境变量指定路径来引用安装的包。 -

modulefile文件命名均采用小写字母,所有依赖 python 的软件,其modulefile文件名中均应指定 python 版本,如arm/rnaframework/2.9.2-py3.11arm/ntsynt/1.0.2-py3.9arm/snpbinner/1.0.0-py2.7;使用了 MPI 的软件,modulefile文件命名中指定使用了哪个MPI,如arm/gflow/0.1.7-openmpiarm/gromacs/2019.5-hmpi等。 -

每个软件的

modulefile文件中均应包含软件的项目地址,github地址优先,方便跟踪。 -

所有软件源码在 package 目录内均应单独建目录,然后在该目录内下载该软件的各种版本、进行编译等,所有软件源码的

tar.gz源码包尽量保留。 -

软件中若有头文件(

xxx.h),应使用CPATH指定路径。 -

软件中若有静态链接库(

xxx.a),应使用LIBRARY_PATH指定路径。 -

软件中若有动态链接库(

xxx.so),应使用LD_LIBRARY_PATH指定路径。 -

软件中若有 pkgconfig 文件(

xxx.pc),应使用PKG_CONFIG_PATH指定路径。 -

软件中若有 cmake 模块文件(

xxx.cmake),应使用CMAKE_PREFIX_PATH指定路径。 -

java 写的 jar 软件,如果没有调用脚本,可以按如下方式编写调用脚本以方便使用,以 trimmomatic 为例

使用#!/bin/bash SCRIPT_DIR="$(cd "$(dirname "${BASH_SOURCE[0]}")" && pwd)" JAR_FILE="${SCRIPT_DIR}/trimmomatic-0.39.jar" if [[ ! -f "$JAR_FILE" ]]; then echo "错误:找不到 $JARAR_FILE" exit 1 fi java -jar "$JAR_FILE" "$@"$ trimmomatic.sh Usage: PE [-version] [-threads <threads>] [-phred33|-phred64] [-trimlog <trimLogFile>] [-summary <statsSummaryFile>] [-quiet] [-validatePairs] [-basein <inputBase> | <inputFile1> <inputFile2>] [-baseout <outputBase> | <outputFile1P> <outputFile1U> <outputFile2P> <outputFile2U>] <trimmer1>... or: SE [-version] [-threads <threads>] [-phred33|-phred64] [-trimlog <trimLogFile>] [-summary <statsSummaryFile>] [-quiet] <inputFile> <outputFile> <trimmer1>... or: -version

静态编译¶

参考:

$ ./configure

checking for gawk... gawk

checking for gcc... gcc

checking whether the C compiler works... no

configure: error: in '/share/home/software/package/samtools/samtools-1.22.1':

configure: error: C compiler cannot create executables

See 'config.log' for more details

# 解决

yum install glibc-static libxcrypt-static libstdc++-static

在 rocky8 上分别编译动态 samtools 和静态 samtools,然后在 centos7 上运行测试。

可以看到静态的 samtools 文件较大,但可以正常运行,动态的 samtools 文件较小,但依赖高版本的 glibc。

$ ldd samtools_static

not a dynamic executable

$ ldd samtools_dynamic

./samtools_d2: /lib64/libm.so.6: version 'GLIBC_2.23' not found (required by ./samtools_d2)

linux-vdso.so.1 => (0x00007fff33b8a000)

/usr/local/bin/snoopy/lib/libsnoopy.so (0x00007fe3ca389000)

libpthread.so.0 => /lib64/libpthread.so.0 (0x00007fe3ca16d000)

libz.so.1 => /lib64/libz.so.1 (0x00007fe3c9f57000)

libm.so.6 => /lib64/libm.so.6 (0x00007fe3c9c55000)

libbz2.so.1 => /lib64/libbz2.so.1 (0x00007fe3c9a45000)

liblzma.so.5 => /lib64/liblzma.so.5 (0x00007fe3c981f000)

...

libcrypto.so.10 => /lib64/libcrypto.so.10 (0x00007fe3c66ca000)

librt.so.1 => /lib64/librt.so.1 (0x00007fe3c64c2000)

libkrb5support.so.0 => /lib64/libkrb5support.so.0 (0x00007fe3c62b2000)

libkeyutils.so.1 => /lib64/libkeyutils.so.1 (0x00007fe3c60ae000)

libresolv.so.2 => /lib64/libresolv.so.2 (0x00007fe3c5e95000)

libsasl2.so.3 => /lib64/libsasl2.so.3 (0x00007fe3c5c78000)

libselinux.so.1 => /lib64/libselinux.so.1 (0x00007fe3c5a51000)

libcrypt.so.1 => /lib64/libcrypt.so.1 (0x00007fe3c581a000)

libpcre.so.1 => /lib64/libpcre.so.1 (0x00007fe3c55b8000)

libfreebl3.so => /lib64/libfreebl3.so (0x00007fe3c53b5000)

$ ll -h

-rwxr-xr-x 1 software software 14M Sep 21 00:49 samtools_static

-rwxr-xr-x 1 software software 9.2M Sep 21 00:13 samtools_dynamic

$ ./samtools_dynamic

./samtools_d2: /lib64/libm.so.6: version 'GLIBC_2.23' not found (required by ./samtools_d2)

$ ./samtools_static --version

samtools 1.22.1

Using htslib 1.22.1

Copyright (C) 2025 Genome Research Ltd.

Samtools compilation details:

Features: build=configure curses=no

CC: gcc

CPPFLAGS:

CFLAGS: -Wall -g -O2

LDFLAGS: -static

HTSDIR: htslib-1.22.1

LIBS:

CURSES_LIB:

HTSlib compilation details:

Features: build=configure libcurl=no S3=no GCS=no libdeflate=no lzma=yes bzip2=no plugins=no htscodecs=1.6.4

CC: gcc

CPPFLAGS:

CFLAGS: -Wall -g -O2 -fvisibility=hidden

LDFLAGS: -fvisibility=hidden

HTSlib URL scheme handlers present:

built-in: file, data, preload

crypt4gh-needed: crypt4gh

mem: mem

autotools¶

一、编译阶段(生成 .o)

| 选项 / 变量 | 作用 | 典型值 |

|---|---|---|

CFLAGS / CXXFLAGS |

让代码本身与位置无关(后续可能进 .so)或强制静态 | -static -fPIC |

-static |

告诉驱动器 “后续只找静态库” | gcc -static |

-fPIC / -fPIE |

生成位置无关代码(必须 若最终要进 .so) | -fPIC |

-ffunction-sections -fdata-sections |

减小编出静态库体积 | |

CPPFLAGS |

头文件搜索路径 | -I/opt/static/include |

二、链接阶段(生成 可执行文件 / .so / .a)

| 选项 / 变量 | 作用 | 示例 |

|---|---|---|

LDFLAGS |

链接器旗标 + 库搜索路径 | -L/opt/static/lib -static |

-static |

生成 纯静态 ELF(无 .dynamic 段) | gcc -static file.o -o file |

-Wl,-Bstatic |

区间内 只链静态库 | -Wl,-Bstatic -lz -lssl -Wl,-Bdynamic |

-Wl,-Bdynamic |

恢复默认动态链接(与上成对) | 同上 |

-Wl,--whole-archive |

把静态库里 所有 .o 都拉进来(解决循环依赖) | -Wl,--whole-archive -lmylib -Wl,--no-whole-archive |

-Wl,-soname=… |

控制 .so 名字(动态库专用) | |

LIBS |

要链的 具体库简称 | -lreadline -lncursesw |

LIBRARY_PATH |

gcc 驱动搜索静态/动态库路径(链接时) | export LIBRARY_PATH=/opt/static/lib |

LD_LIBRARY_PATH |

运行时搜索 .so(对静态链接无意义) |

三、ar / ranlib(打包静态库)

| 工具 | 变量 | 默认 | 说明 |

|---|---|---|---|

ar |

AR / ARFLAGS |

ar cr |

创建 .a |

ranlib |

RANLIB |

ranlib |

生成索引,加快链接 |

四、configure 常见开关

| 选项 | 含义 |

|---|---|

--enable-static |

把 软件包自己编出静态库(如 libxxx.a) |

--disable-shared / --enable-shared=no |

禁止生成 .so |

--enable-R-static-lib(R 专属) |

让 R 把 blas/lapack 等静态链进可执行文件 |

--with-static-the-system |

少数包提供,等价于 -static 全套 |

五、静态链接“找不到符号”速查

| 症状 | 检查项 |

|---|---|

ld: cannot find -lxxx |

1. 真没 libxxx.a2. 没加 -L/path |

relocation against … can not be used |

库未用 -fPIC 重编(要进 .so 时) |

undefined reference to symbol` |

顺序错,被依赖的放右边;或用 --whole-archive |

一键静态

export CC="gcc -static"

export CPPFLAGS="-I/opt/static/include"

export LDFLAGS="-L/opt/static/lib -static"

export LIBS="-lssl -lcrypto -lz -ldl -pthread"

./configure --disable-shared --enable-static

make

libtool¶

在编译二进制文件时,在 XXX_LINK中$(CCLD)后面添加-all-static即可起效。一般的LDFLAG、CFLAG等对libtool无效

-static` 的方式测试无效

iperf3_LINK = $(LIBTOOL) $(AM_V_lt) --tag=CC $(AM_LIBTOOLFLAGS) \

$(LIBTOOLFLAGS) --mode=link $(CCLD) -all-static $(iperf3_CFLAGS) $(CFLAGS) \

$(iperf3_LDFLAGS) $(LDFLAGS) -o $@

LTCOMPILE = $(LIBTOOL) $(AM_V_lt) --tag=CC $(AM_LIBTOOLFLAGS) \

$(LIBTOOLFLAGS) --mode=compile $(CC) -static $(DEFS) \

$(DEFAULT_INCLUDES) $(INCLUDES) $(AM_CPPFLAGS) $(CPPFLAGS) \

$(AM_CFLAGS) $(CFLAGS)

libtool looks at the parameters of gcc, so you should have something like below

$ cat Makefile

all: libone libtwo

rm *.o

@libtool --mode=link gcc -all-static -o libcombo.a libone.a libtwo.a

libone: one.c

@libtool --mode=compile gcc -c one.c -o one.lo

@libtool --mode=link gcc -static -o libone.a one.lo

libtwo: two.c

@libtool --mode=compile gcc -c two.c -o two.lo

@libtool --mode=link gcc -static -o libtwo.a two.lo

cmake¶

一、控制「库」本身的类型

| 变量 / 指令 | 作用 | 典型值 |

|---|---|---|

BUILD_SHARED_LIBS |

全局开关,ON=动态/OFF=静态 |

-DBUILD_SHARED_LIBS=OFF |

add_library(foo STATIC …) |

显式声明 静态库 | |

add_library(foo SHARED …) |

显式声明 动态库 | |

add_library(foo …) 无参数 |

由 BUILD_SHARED_LIBS 决定 |

二、编译阶段(生成 .o)

| 变量 | 说明 | 示例 |

|---|---|---|

CMAKE_C_FLAGS / CMAKE_CXX_FLAGS |

给 所有目标 加选项 | -static -fPIC |

target_compile_options(foo PRIVATE -fPIC) |

只给指定目标加 | |

add_compile_options(-fPIC) |

全局生效 |

若要把静态库 再链进动态库,静态库本身必须带 -fPIC,否则链接时报 can not be used when making a shared object; recompile with -fPIC

三、链接阶段(生成 可执行文件 / .so / .a)

| 变量 | 说明 | 示例 |

|---|---|---|

CMAKE_EXE_LINKER_FLAGS |

可执行文件 链接旗标 | -static |

CMAKE_SHARED_LINKER_FLAGS |

动态库 链接旗标 | |

CMAKE_STATIC_LINKER_FLAGS |

静态库 链接旗标(很少用) | |

target_link_libraries(foo PRIVATE -static) |

对单个目标加 -static |

|

target_link_libraries(foo PRIVATE -Wl,-Bstatic -lz -Wl,-Bdynamic) |

区间静态链接 |

纯静态可执行文件: set(CMAKE_EXE_LINKER_FLAGS "-static") 即可让 最终 ELF 无 .dynamic 段

四、查找 & 强制使用 静态库

| 命令 / 变量 | 说明 | 示例 |

|---|---|---|

find_package(ZLIB REQUIRED) |

先找到包 | |

set(ZLIB_USE_STATIC_LIBS ON) |

官方 Find 模块识别后只选 .a |

CMake ≥ 3.24 |

find_library(ZLIB_STATIC NAMES z libz PATHS /opt/static/lib) |

手动找 libz.a |

|

target_link_libraries(foo PRIVATE ${ZLIB_STATIC}) |

直接给 绝对路径 链入 |

一键静态

cmake -B build -G Ninja \

-DCMAKE_BUILD_TYPE=Release \

-DBUILD_SHARED_LIBS=OFF \

-DCMAKE_EXE_LINKER_FLAGS="-static" \

-DCMAKE_C_FLAGS="-fPIC" \

-DCMAKE_CXX_FLAGS="-fPIC" \

-DZLIB_USE_STATIC_LIBS=ON \

-DCMAKE_INSTALL_PREFIX=/opt/static

cmake --build build

anchorwave¶

项目地址 https://github.com/baoxingsong/anchorwave

git clone https://github.com/baoxingsong/anchorwave.git

cd anchorwave

mv CMakeLists_arm.txt CMakeLists.txt

cmake ./

make

Amber¶

项目地址 https://ambermd.org/GetAmber.php

参考文档 https://ambermd.org/doc12/Amber24.pdf

module load gcc/compiler/gccmodule gcc/hmpi/hmpi

tar xf Amber24.tar.bz2

tar xf AmberTools24.tar.bz2

pip install --prefix=/path/to/amber/ numpy scipy matplotlib

cd amber24_src

$ ./update_amber --update

cd build

run_cmake 文件中 cmake 的参数,然后再运行 run_cmake。

修改后如下,指定安装目录、启用 MPI、禁用 conda

cmake $AMBER_PREFIX/amber24_src \

-DCMAKE_INSTALL_PREFIX=/share/software/app/arm/amber/24/ \

-DCOMPILER=GNU \

-DMPI=TRUE -DCUDA=FALSE -DINSTALL_TESTS=TRUE \

-DDOWNLOAD_MINICONDA=FALSE \

2>&1 | tee cmake.log

run_cmake 运行完成后,再运行 make install 安装。

source /share/software/app/arm/amber/24/amber.sh 后即可使用。

AnnoPRO¶

https://github.com/idrblab/AnnoPRO

依赖库 profeatpy 在 github 上的源码包被删了,无法编译安装这个包。

apbs¶

项目地址

github.com/Electrostatics/apbs

https://apbs.readthedocs.io/en/latest/index.html

$ tar xf apbs-3.4.1.tar.gz

$ cd apbs-3.4.1

$ mkdir build && cd build

$ export APBS_BUILD_DIR=${PWD}

$ export SuiteSparse_DIR="/path/to/suitesparse/"

$ export CMAKE_PREFIX_PATH="/path/to/suitesparse/:$CMAKE_PREFIX_PATH"

$ cmake .. -DUMFPACK_INCLUDES=/path/to/suitesparse/include/suitesparse/umfpack.h -DUMFPACK_LIBRARIES=/path/to/suitesparse/lib64/libumfpack.a -DAMD_INCLUDE_DIR=/path/to/suitesparse/include/suitesparse/ -DAMD_STATIC=/path/to/suitesparse/lib64/libamd.a -DPython3_EXECUTABLE=/usr/bin/python3 -DCMAKE_C_COMPILER=`which gcc` -DCMAKE_CXX_COMPILER=`which g++` -DCMAKE_C_FLAGS="-fopenmp" -DCMAKE_CXX_FLAGS="-fopenmp"

$ make -j

$ make install

Augustus¶

项目地址:https://github.com/Gaius-Augustus/Augustus/

参考 https://github.com/Gaius-Augustus/Augustus/blob/master/docs/INSTALL.md

$ wget http://bioinf.uni-greifswald.de/augustus/binaries/augustus.current.tar.gz

$ tar -xzf augustus.current.tar.gz

$ cd augustus

common.mk 文件,将 COMPGENEPRED = true 更改为 COMPGENEPRED = false,添加 MYSQL = false

编译 make augustus

如果需要编译 augustus 及其它相关工具。

$ module load arm/bamtools/2.5.2 arm/htslib/1.21

$ tar -xzf augustus.current.tar.gz

$ cd augustus

$ make

ATLAS¶

$ mkdir build && cd build

$ ../configure --prefix=/path/to/atlas/ -Si archdef 0 -b 64 -D c -DATL_ARM_HARDFP=1 --cripple-atlas-performance

# make -j 20 会报错

$ make && make install

# 查看安装的库

$ $ ls -1 /path/to/atlas/

libatlas.a

libcblas.a

libf77blas.a

liblapack.a

libptcblas.a

libptf77blas.a

BatMeth2¶

项目地址:https://github.com/GuoliangLi-HZAU/BatMeth2

$ git clone https://github.com/GuoliangLi-HZAU/BatMeth2.git

$ cp ~/package/sse2neon.h src/mealign/

$ sed -i.bak 's/<emmintrin.h>/"sse2neon.h"/g' ./src/mealign/ksw.c

$ sed -i.bak 's/-m64/ /g' ./src/Makefile

$ ./configure --prefix=/path/to/batmeth2/

$ make -j20 && make install

BLAT¶

最新版 https://hgdownload.soe.ucsc.edu/admin/,下载 jksrc.xxx.zip,BLAT 位于 kent/src/blat,不容易编译成功。

编译好的 x86 版本 https://hgdownload.soe.ucsc.edu/admin/exe/linux.x86_64/blat/

可编译版本

$ wget https://codeload.github.com/djhshih/blat/tar.gz/v35.1

$ mv v35.1 blat_35.1.tar.gz

$ tar xf blat_35.1.tar.gz

$ cd blat-35.1/

$ make

# 或编译静态库版本

$ CFLAGS="-static -static-libgcc -D_STATIC" make

BerkeleyDB¶

项目地址 https://github.com/berkeleydb/libdb/

$ wget https://github.com/berkeleydb/libdb/releases/download/v5.3.28/db-5.3.28.tar.gz

$ tar xf db-5.3.28.tar.gz

$ cd db-5.3.28/build_unix

$ ../dist/configure --build=aarch64-unknown-linux-gnu --prefix=/path/to/berkeley-db/

$ make -j20 && make install

bmtagger¶

https://ftp.ncbi.nlm.nih.gov/pub/agarwala/bmtagger/

$ wget https://ftp.ncbi.nlm.nih.gov/pub/agarwala/bmtagger/bmtagger.sh

$ wget https://anaconda.org/bioconda/bmfilter/3.101/download/linux-aarch64/bmfilter-3.101-h78569d1_5.tar.bz2

$ wget https://anaconda.org/bioconda/srprism/2.4.24/download/linux-aarch64/srprism-2.4.24-h76f4f2e_5.tar.bz2

$ wget https://conda.anaconda.org/bioconda/linux-aarch64/extract_fullseq-3.101-h78569d1_5.tar.bz2

$ tar xf *bz2

$ ls -1 bin/

bmfilter

extract_fullseq

srprism

$ module load arm/blast/2.16.0

bmtagger.conf

#!/bin/sh

echo "bmtagger.sh: You may want to edit bmtagger.conf" >&2

SRPRISM=./bin/srprism

BMFILTER="./bin/bmfilter"

EXTRACT_FA="./bin/extract_fullseq"

#bmfiles="hs/quick_mask/indexes/washu_mask18"

#blastdb="hs/quick_mask/indexes/HUMAN_SCREENING"

#srindex="hs/quick_mask/indexes/HUMAN_SCREENING.srprism"

#TMPDIR="/tmp"

https://ftp.ncbi.nlm.nih.gov/pub/agarwala/bmtagger/bmtools.tar.gz 这个源码包可以独立编译 srprism bmfilter extract_fullseq 但有编译报错。

blast+¶

可以在 https://ftp.ncbi.nlm.nih.gov/blast/executables/blast+/LATEST/ 中下载编译好的版本。

$ wget https://ftp.ncbi.nlm.nih.gov/blast/executables/blast+/LATEST/ncbi-blast-2.16.0+-aarch64-linux.tar.gz

bwa-mem2¶

项目地址 https://github.com/bwa-mem2/bwa-mem2

# 下载二进制版本

wget https://anaconda.org/bioconda/bwa-mem2/2.2.1/download/linux-aarch64/bwa-mem2-2.2.1-h0010869_6.tar.bz2

cactus¶

项目地址 https://github.com/ComparativeGenomicsToolkit/cactus

git clone https://github.com/ComparativeGenomicsToolkit/cactus.git --recursive

cd cactus

setup.py 文件中22行的 subprocess.run([sys.executable, "-m", "pip", "install", "submodules/sonLib"], check=True) 注释掉,以免将 sonLib 安装到了 python 的默认目录。

make -j20

pip install --prefix=/path/to/cactus/ submodules/sonLib

pip install --prefix=/path/to/cactus/ .

pip install --prefix=/path/to/cactus/ -r toil-requirement.txt

cereal¶

https://github.com/USCiLab/cereal

unittests/CMakeLists.txt unittests/boost/CMakeLists.txt unittests/cpp17/CMakeLists.txt 中所有 -m32 删除

删除 CMakeLists.txt 中部分编译选项

add_compile_options(-Wall -Wextra -pedantic -Wshadow -Wold-style-cast) 更改为 add_compile_options(-Wall -Wextra -pedantic )

add_compile_options(-Werror) 更改为 add_compile_options()

$ mkdir build

$ cd build

$ cmake -DCMAKE_INSTALL_PREFIX=/path/to/cereal/ -DBoost_INCLUDE_DIR=/path/to/boost/include/ ..

$ make -j12

$ make install

circos¶

项目地址 https://circos.ca/software/download/circos/

$ wget https://circos.ca/distribution/circos-0.69-10.tgz

$ tar xf circos-0.69-10.tgz

$ cd circos-0.69-10

$ module load arm/perl/5.34.0

# 查看确实的 perl 模块

$ bin/circos -modules|grep missing

missing Font::TTF::Font

missing GD

missing GD::Polyline

missing Math::Bezier

missing Math::Round

missing Math::VecStat

missing Params::Validate

missing Regexp::Common

missing Set::IntSpan

missing Statistics::Basic

missing Text::Format

# 安装缺失的 perl 模块

$ cpanm -l /share/software/app/arm/perl/5.34.0/ Text::Format Statistics::Basic Set::IntSpan Regexp::Common Params::Validate Math::VecStat Math::Round Math::Bezier Font::TTF::Font

# 加载 libgd 用于安装 GD 模块,注意 libgd 版本需要低于 2.3,否则 GD 模块安装会报错

# 报错是高版本的 libgd 中没有 gdlib-config 导致的

$ module load arm/libgd/2.2.5

$ cpanm -l /share/software/app/arm/perl/5.34.0/ GD GD::Polyline

# 测试

$ bin/circos -conf /share/software/app/arm/circos/0.69-10/example/etc/circos.conf

clustalw¶

项目地址 http://www.clustal.org/download/current/

wget http://www.clustal.org/download/current/clustalw-2.1.tar.gz

tar xf clustalw-2.1.tar.gz

cd clustalw-2.1/

./configure --build=arm --prefix=/path/to/clustalw/

make -j20 && make install

cmake¶

直接下载编译好的 aarch64 版本 cmake-3.30.5-linux-aarch64.sh

cppunit¶

https://freedesktop.org/wiki/Software/cppunit/

$ tar xf cppunit-1.13.2.tar.gz

$ cd cppunit-1.13.2

$ ./configure --prefix=/path/to/cppunit/ --build=aarch64-unknown-linux-gnu

$ make -j20 && make install

bowtie2¶

直接下载编译好的二进制文件

https://github.com/BenLangmead/bowtie2/releases

EDTA (todo)¶

https://github.com/liaoherui/AnnoSINE_v2

mamba create -n EDTA2.2 -c conda-forge -c bioconda annosine2 biopython cd-hit coreutils genericrepeatfinder genometools-genometools glob2 tir-learner ltr_finder_parallel ltr_retriever mdust multiprocess muscle openjdk perl perl-text-soundex r-base r-dplyr regex repeatmodeler r-ggplot2 r-here r-tidyr tesorter samtools bedtools LTR_HARVEST_parallel HelitronScanner

glob2

https://github.com/lutianyu2001/TIR-Learner

elai¶

项目地址 https://github.com/haplotype/ELAI

$ git clone https://github.com/haplotype/ELAI

$ cd src

修改 Makefile 文件

CFLAGS += -Wall -fno-math-errno -ffast-math 修改为 CFLAGS += -Wall -fno-math-errno -ffast-math -fsigned-char,即添加 -fsigned-char 编译选项

STATICLIBS += /usr/local/lib/libgsl.a /usr/local/lib/libgslcblas.a 修改为 STATICLIBS += /share/software/app/arm/gsl/2.7/lib/libgsl.a /share/software/app/arm/gsl/2.7/lib/libgslcblas.a

最后编译 make。

Warning

编译时不添加 -fsigned-char 编译选项也能编译成功,但运行不出结果。

测试

cd ../example

$ ../src/elai -g hap.ceu.chr22.inp -p 10 -g hap.yri.chr22.inp -p 11 -g admix-1cm.inp -p 1 -pos hgdp.chr22.pos -o test -s 20 --exclude-nopos --exclude-maf 0.01 --exclude-miss1 -mg 20

emboss¶

项目地址 https://emboss.sourceforge.net/

$ wget https://anaconda.org/bioconda/emboss/6.6.0/download/linux-aarch64/emboss-6.6.0-h70f19aa_11.tar.bz2

eggnog-mapper¶

项目地址 https://github.com/eggnogdb/eggnog-mapper

# 2.1.13

pip install --prefix=/path/to/eggnog-mapper eggnog-mapper

# eggnog-mapper 安装包自带了这几个软件的预编译版,但都是 x86 的,使用时需要载入 arm 版

# eggnog-mapper 会优先使用 $PATH 中有的软件,然后再使用自己安装的

$ module load arm/diamond/2.1.10 arm/prodigal/2.6.3 arm/mmseqs2/16-747c6 arm/hmmer/3.4

$ emapper.py -h

下载数据库

更改代码

将 download_eggnog_data.py 中 BASE_URL = f'http://eggnogdb.embl.de/download/emapperdb-{__DB_VERSION__}' 改为 BASE_URL = f'http://eggnog5.embl.de/download/emapperdb-{__DB_VERSION__}'。

# 2759 是真核数据库,一路 Y 就可以了

$ download_eggnog_data.py -F -f -P -M -H -d 2759

EVM¶

项目地址 https://github.com/EVidenceModeler/EVidenceModeler/

$ tar xf EVidenceModeler-v2.1.0.tar.gz

$ cd EVidenceModeler-v2.1.0

plugins/ParaFly/configure 中第 3123 行的 AM_CXXFLAGS=-m64 注释掉。

$ make

exonerate¶

下载二进制版本

$ wget https://anaconda.org/bioconda/exonerate/2.4.0/download/linux-aarch64/exonerate-2.4.0-he4d9ad3_8.tar.bz2

fastlmm¶

需要替换 Cpp/Inc/BlasLapack.h 中数学库,源码中使用的 intel MKL 数学库。

| intel MKL | openblas | KML |

|---|---|---|

| sscal | cblas_sscal | cblas_sscal |

| dscal | cblas_dscal | cblas_dscal |

| scopy | cblas_scopy | cblas_scopy |

| dcopy | cblas_dcopy | cblas_dcopy |

| sgemv | cblas_sgemv | cblas_sgemv |

| dgemv | cblas_dgemv | cblas_dgemv |

| sgemm | cblas_sgemm | cblas_sgemm |

| dgemm | cblas_dgemm | cblas_dgemm |

| ssyrk | cblas_ssyrk | cblas_ssyrk |

| dsyrk | cblas_dsyrk | cblas_dsyrk |

| spotrf | LAPACKE_spotrf | spotrf_ |

| dpotrf | LAPACKE_dpotrf | dpotrf_ |

| spotrs | LAPACKE_spotrs | spotrs_ |

| dpotrs | LAPACKE_dpotrs | dpotrs_ |

| sgesdd | LAPACKE_sgesdd | sgesdd_ |

| dgesdd | LAPACKE_dgesdd | dgesdd_ |

| ssyevr | LAPACKE_ssyevr | ssyevd_ |

| dsyevr | LAPACKE_dsyevr | dsyevd_ |

| sgelsy | LAPACKE_sgelsy | sgelsy_ |

| dgelsy | LAPACKE_dgelsy | dgelsy_ |

| vsLn | for (BLAS_INT i = 0; i < n; ++i) | vslog2 |

| vdLn | vdlog2 | |

| vsSqrt | for (BLAS_INT i = 0; i < n; ++i) | vssqrt |

| vsSqrt | vdsqrt |

fastqc¶

https://anaconda.org/bioconda/fastqc

直接下载编译好的二进制文件

$ wget https://anaconda.org/bioconda/fastqc/0.12.1/download/noarch/fastqc-0.12.1-hdfd78af_0.tar.bz2

fastp¶

安装依赖库 isa-l,libdeflate,如果没有 libstdc++.a,也需要安装 gcc。最后使用静态库编译fastp,使用时不用另外载入依赖库。

# 设置静态库地址

$ export LIBRARY_PATH=/path/to/isa-l/lib/:/path/to/libdeflate/lib/:/path/to/gcc/lib64/

$ git clone https://github.com/OpenGene/fastp.git

$ cd fastp

$ make -j12 static

fastStructure¶

- python3

项目地址 https://github.com/rajanil/fastStructure/issues/63

原项目基于python2,安装 scipy 出现报错。

因此实际编译安装使用python3的版本 https://github.com/jashapiro/fastStructure

git clone https://github.com/jashapiro/fastStructure.git

cd fastStructure

git checkout py3

部分代码需要更改

parse_bed.pyx 中

25 行的Nbytes = Nindiv/4+(Nindiv%4>0)*1 更改为 Nbytes = Nindiv//4+(Nindiv%4>0)*1

48 行的 print "This is not a valid bed file" 更改为 print("This is not a valid bed file")

fastStructure.pyx 中

305 行的 print "Failed" 更改为 print("Failed")

$ module load arm/gsl/2.4

$ pip install --prefix=/path/to/faststructure/ numpy scipy cython

$ cd var

$ PYTHONPATH=/path/to/faststructure/1.0/lib64/python3.9/site-packages/:/path/to/faststructure/1.0/lib/python3.9/site-packages/ python setup.py build_ext -f --inplace

$ cd ..

$ PYTHONPATH=/path/to/faststructure/1.0/lib64/python3.9/site-packages/:/path/to/faststructure/1.0/lib/python3.9/site-packages/ python setup.py build_ext -f --inplace

# 测试,将 ./var/ 加入 PYTHONPATH,否则出现 allelefreq 相关报错

$ PYTHONPATH=/path/to/faststructure/1.0/lib64/python3.9/site-packages/:/path/to/faststructure/1.0/lib/python3.9/site-packages/:$PWD python structure.py -h

运行测试算例

PYTHONPATH=//path/to/faststructure/faststructure/1.0/lib64/python3.9/site-packages/://path/to/faststructure/faststructure/1.0/lib/python3.9/site-packages/ python structure.py -K 3 --input=test/testdata --output=testoutput_simple --full --seed=100

出现报错,暂时未能解决。

Traceback (most recent call last):

File "//path/to/faststructure/fastStructure/structure.py", line 176, in <module>

Q, P, other = fastStructure.infer_variational_parameters(G, params['K'], \

File "fastStructure.pyx", line 99, in fastStructure.infer_variational_parameters

psi.update(G, pi)

TypeError: Cannot convert allelefreq.AlleleFreq to allelefreq.AlleleFreq

参考

https://github.com/rajanil/fastStructure/issues/63

https://github.com/rajanil/fastStructure/issues/81

- python2

$ module load arm/python/2.7.18

$ git clone https://github.com/rajanil/fastStructure/

$ cd fastStructure

$ pip install --prefix=/path/to/fastStructure/ numpy

# 设置编译参数 -fallow-argument-mismatch,否则 scipy 编译过程中出现报错 Error: Rank mismatch between actual argument at (1) and actual argument at (2) (scalar and rank-1)

$ export FCFLAGS="-fallow-argument-mismatch"

$ export FFLAGS="-fallow-argument-mismatch"

$ PYTHONPATH=/path/to/lib/python2.7/site-packages/ pip install --prefix=/path/to/fastStructure/ scipy Cython matplotlib

parse_bed.pyx 和 fastStructure.pyx 顶部添加 # cython: language_level=2 表示使用 python2 编译 cpython

$ cd vars

$ PYTHONPATH=/path/to/lib/python2.7/site-packages/ python setup.py build_ext -f --inplace

$ cd ..

$ PYTHONPATH=/path/to/lib/python2.7/site-packages/ python setup.py build_ext -f --inplace

# 测试

$ PYTHONPATH=/path/to/lib/python2.7/site-packages/:$PWD/vars/ python structure.py -h

PYTHONPATH=//path/to/faststructure/faststructure/1.0/lib/python2.7/site-packages/ python structure.py -K 3 --input=test/testdata --output=testoutput_simple --full --seed=100

FastTree¶

$ wget http://meta.microbesonline.org/fasttree/FastTree.c

$ gcc -DOPENMP -DUSE_DOUBLE -fopenmp -O3 -march=armv8.2-a -mtune=tsv110 -finline-functions -funroll-loops -Wall -o FastTreePar-2.1.11 FastTree.c -lm

$ export OMP_NUM_THREADS=128

fftw¶

参考

$ module load arm/openmpi/5.0.5

$ wget wget https://fftw.org/pub/fftw/fftw-3.3.8.tar.gz

$ tar xf fftw-3.3.8.tar.gz

$ cd fftw-3.3.8/

$ ./configure --prefix=/path/to/fftw/ --enable-single --enable-float --enable-neon --enable-shared --enable-threads --enable-openmp --enable-mpi CFLAGS="-O3 -fomit-frame-pointer -fstrict-aliasing"

$ make -j20

$ make install

flye¶

项目地址 https://github.com/mikolmogorov/Flye/

wget wget https://anaconda.org/bioconda/flye/2.9.5/download/linux-aarch64/flye-2.9.5-py39h989d1c4_2.tar.bz2

tar xf flye-2.9.5-py39h989d1c4_2.tar.bz2

GATK¶

intel GKL

# 下载这个 arm64 分支

git clone -b devel https://github.com/syalavarthi/GKL.git

cd GKL

gradle-5.6-bin.zip,将其再放在 /share/home/software/.gradle/wrapper/dists/gradle-5.6-bin/gradle-5.6-bin.zip,将 gradle/wrapper/gradle-wrapper.properties 中的 distributionUrl=https\://services.gradle.org/distributions/gradle-3.2.1-all.zip 替换为 distributionUrl=file:/share/home/software/.gradle/wrapper/dists/gradle-5.6-bin/gradle-5.6-bin.zip。